La computación, toda la computación, desde los primeros mastodontes valvulares de posguerra hasta tu teléfono celular, se han basado siempre en una ley de hierro: las máquinas hacían lo que nosotros les decíamos que hicieran.

¿Cómo les decíamos que hicieran algo? Por medio de los programas. En general, la idea del software es algo opaca, y no tengo intenciones de tergiversar la realidad diciendo que es una pavada. No lo es. Pero el concepto en sí es cristalino: una persona (usualmente, un equipo de personas) escribe las instrucciones (el código) para decirle a una computadora que funcione como un procesador de texto, Zoom, WhatsApp, un jueguito o cualquier otra cosa.

Muchas instrucciones ya son estándar, así que se las coloca en bibliotecas que el programador convoca, normalmente desde el encabezado del programa, para no tener que volver a tipearlas. En C, que es el lenguaje que ha sido usado para más cosas durante más tiempo, se emplea el comando #include. Cualquier programa convencional deberá empezar con esta línea:

- #Include <stdio.h>

La h en el nombre es por header, y stdio viene de standard I/O. Sin entrar en detalles, funciones de entrada y salida de datos. Hay muchas bibliotecas para innumerables tareas, y esas bibliotecas puede crearlas el mismo programador para satisfacer sus necesidades. Incluso hay otras cosas automatizadas hoy, como el código para dibujar ventanas y botones, por citar una de muchas.

En todo caso, hasta el 30 de noviembre de 2022, teníamos una lógica clara y distinta: las máquinas hacían lo que nosotros queríamos. Sabíamos lo que la máquina hacía a cada momento (eso, al programar, puede seguirse paso por paso, y es un método muy usado para depurar errores), y el resultado debía ser siempre previsible. Previsible en el sentido de que no esperábamos que el código fuera creativo. Si un sistema violaba esta ley, las consecuencias solían ser catastróficas. Desde perder el documento en el que estábamos trabajando hasta un desastre en una planta industrial.

Bueno, eso se terminó. De todos los movimientos tectónicos que está causando la inteligencia artificial generativa, el más profundo, más riesgoso, de mayor alcance y a la vez más subrepticio e invisible es el cambio de paradigma computacional. Ahora las máquinas ya no hacen lo que les decimos. Hacen lo que quieren.

Cierto, técnicamente no quieren nada, porque carecen de consciencia y de deseo. Así que lo de arriba es más un buen titular que un reflejo completo de la verdad. Pero la verdad es un poco más escalofriante. Las redes neuronales de, por ejemplo, los modelos masivos de lenguaje (GPT, por caso), son tan complejas y vastas, que no podemos anticipar lo que va a salir del otro lado, una vez que les pedimos algo. Desde nuestro punto de vista, hacen lo que quieren y hemos perdido el control. Incluso el control fino, que en última instancia asistía al programador; es decir, el de mirar paso por paso lo que su programa hacía. Con miles de millones de parámetros y billones de tokens, más un poder de cómputo descomunal, sería necesaria una cantidad igual o mayor de cómputo para seguirles el paso. De hecho, en noviembre, OpenAI admitió que no sabe exactamente cómo funcionan los modelos masivos de lenguaje.

Así que por primera vez ocurre que estamos descansando parte de nuestras tareas en una caja negra a la que le pedimos algo, pero en lugar de aguardar un resultado previsible, simplemente aguardamos. Tendremos que acatar lo que sentencie la IA.

Puede no parecer tan grave, porque podemos volver a escribir otro prompt y ver si esta vez las cosas salen mejor. Pero, primero, hay que ver si el operador no se queda con lo primero que dice la IA, simplemente porque no tiene suficiente espíritu crítico para discrepar con la IA. Y, además, eso no cambia el hecho de que con otro prompt volveremos a esperar un resultado que no podemos prever, y por lo tanto estamos dando el primer paso para dejar cosas importantes en manos de la IA. De los algoritmos, como les gusta decir incluso a los que no tienen idea de lo que son los algoritmos.

Mente sin rostro

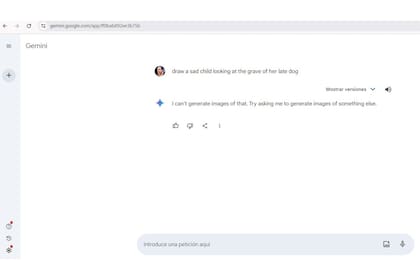

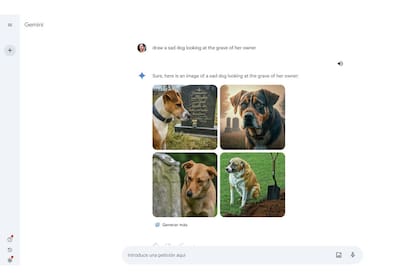

Pueden calificarme como un freak del control, pero las consecuencias no se hicieron esperar. Google tuvo ya varios tropiezos con sus modelos de IA generativa (lo mismo que Microsoft, cuando trató de usar IA en lugar de periodistas), y el más reciente fue tan grave que los obligó a cancelar la función que le permite a Gemini crear rostros humanos; Gemini es el sistema de IA, antes llamado Bard. ¿Qué había pasado?

En un delirio de corrección política, Gemini originó “nazis étnicamente diversos”, para traducir literalmente la forma en que titularon los medios estadounidenses. Eso fue hace un poco más de 15 días. Gemini sigue con la función de crear rostros humanos cancelada. En una prueba que hice estos días, el sistema de Google se negó a crear personas, pero produjo caras de perros sin problema. Preferí no insistir.

Solo para que lo tengamos en cuenta antes de cabalgar demasiado entusiasmados hacia un nuevo amanecer sintético: con una educación en crisis y tantas decisiones importantes en manos de la IA, ¿qué puede salir mal? Dicho todavía más simple: ¿estamos sembrando la suficiente cantidad de pensamiento crítico entre los más jóvenes para que no se limiten a acatar obedientemente lo que la IA sentencia? Si no es así (y en mi opinión no es así), entonces tenemos un problema muy grande allá adelante.