Introducción de AgendAR:

Alan Turing, inventor de la cibernética y el hackeo, predijo hace medio siglo que el software llegaría a imitar la conversación por escrito entre humanos de un modo casi perfecto.

Tanto así, escribió Turing, que en el 70% de los casos el programa, montado sobre una capacidad de cómputo inimaginable en los años ’50, lograría convencer cualquier interlocutor humano en el otro extremo del teclado de que estaba chateando con otra persona bípeda y real.

Añadió que eso sucedería alrededor de 2000. Era un optimista: le erró por 25 años, acaba de suceder. Y Turing se quedó corto. La versión 4,5 de Chat GPT engaña al 73% de los humanos.

Su país y la vida le pagaron mal a Turing. Como máxima autoridad técnica de los desencriptadores de la inteligencia militar británica, logró crackear los códigos Enigma de la fuerzas armadas de la Alemania nazi.

Para ello, desarrolló los recursos humanos civiles, asistidos por la primera supercomputadora programable de los ’40, en Benchley Park, una mansión victoriana rodeada de parque en un anónimo suburbio rural de Londres, libre de espiás y bombas alemanas.

Adolf Hitler y la cúpula militar y de inteligencia nazi no se enteraron jamás de que sus comunicaciones eran leídas casi en tiempo real por el espionaje inglés.

La supercomputadora se llamaba Colossus, consumía tanta electricidad como una pequeña fábrica de vidrio, funcionaba a válvulas que no aguantaban su propio calor y se quemaban a cada rato, y fue la mejor del mundo hasta

el final de la guerra.

La US Navy desarrolló, bajo el mando del capitán Joe Rochefort, un equipo de linguistas y matemáticos para otra para hazaña criptográfica: descifrar los códigos J-25 de la Armada Imperial japonesa. Era la mayor y más temible del planeta en 1939.

A medio año de perder casi toda la flota del Pacífico, y tras la batalla de Midway en 1942, este crackeo le costó a Japón todos sus portaaviones de batalla y su aviación naval, y casi la totalidad de sus submarinos, acorazados, cruceros, destructores y sobre todo, de sus convoyes logísticos.

Debido a Rochefort, anónimo nerd que jamás disparó sobre un japonés y raramente se dejó mandonear por el almirantazgo yanqui, Japón estaba derrotado y condenado al frío, la devastación y el hambre popular desde el comienzo de la guerra. Pero se enteró de ello mucho después.

Eso se hizo a pura fuerza de neuronas y algunas computadoras IBM nada notables, sin la fuerza bruta de cálculo ni la flexibilidad de programación de la bestia mitad humana, mitad máquina que creó Turing.

Es imposible cuantificar en cuántos meses o años acortó Colossus y su banco de recursos humanos el triunfo de los Aliados, especialmente durante los tres años de la llamada Batalla del Atlántico. En ella murió el 75% de los submarinistas de la Kriegsmarine.

Los destructores y aviones antisubmarinos yanquis, canadienses y británicos en general sabía adónde estaba cada «manada de lobos», y las iba reventando. De tanto en tanto las dejaban destruir algún convoy, no fueran a enterarse de que les leían cada comunicación.

«En la historia de los conflictos humanos, nunca tantos le debieron tanto a tan pocos», dijo Winston Churchill de los pilotos de la RAF, pasado el peor momento de la Batalla de Batalla aérea de Gran Bretaña.

Podría haberle dedicado una frase igualmente memorable a Turing y al elenco de aficionadas a los crucigramas, y freaks de la matemática. Pero la gratitud nunca cue el fuerte del Prime Minister británico, y al final de la guerra caliente y comienzos de la fría, era mejor que la URSS ignorara la capacidad británica de leerle la mente a Josip Stalin.

Por lo demás, Turing era discretamente homosexual. La aristocracia que dirigía al Imperio Británico también, pero no era cuestión de homenajear a un cofrade al que le debió sobrevivir a la guerra. De modo En 1952, Turing fue acusado ante la ley, que prohibía la homosexualidad, y los jueces a cargo, magnánimos, le dieron a elegir entre la cárcel y la castración química con inhibidores de la testoesterona.

Con lo cual el buen Alan, atleta no sólo de la mente sino del deporte, engordó, perdió todo deseo sexual y entró en depresión.

En 1954 Turing se suicidó, discretamente y a lo inglés, sin que a la alta sociedad británica se le moviera un pelo.

En 2013 la Reina Isabel II, le otorgó a Turing su perdón, lo que confirma que Turing fue demasiado inteligente para su tiempo y su país, y que la monarquía local no sólo vive en el Pleistoceno, sino que sigue espectacularmente pelotuda.

Perdón por tanto preámbulo: había que describir a Turing.

Antes de matarse y en tiempos de la electrónica valvular, el tipo pronosticó con bastante acierto cuándo y de qué manera al menos una de las muchas inteligencias artificiales en el mercado actual se volvería un 70% imposible de diferenciar de la tuya y de la mía.

Turing tenía razón. Acaba de suceder.

Es bueno y un poco escalofriante que la humanidad se entere.

Daniel E. Arias

ooooo

Parece que cada día aparece un nuevo titular sobre las crecientes capacidades de los grandes modelos de lenguaje (LLM) como ChatGPT y Gemini de Google, titulares que son emocionantes o cada vez más apocalípticos, según el punto de vista de cada uno.

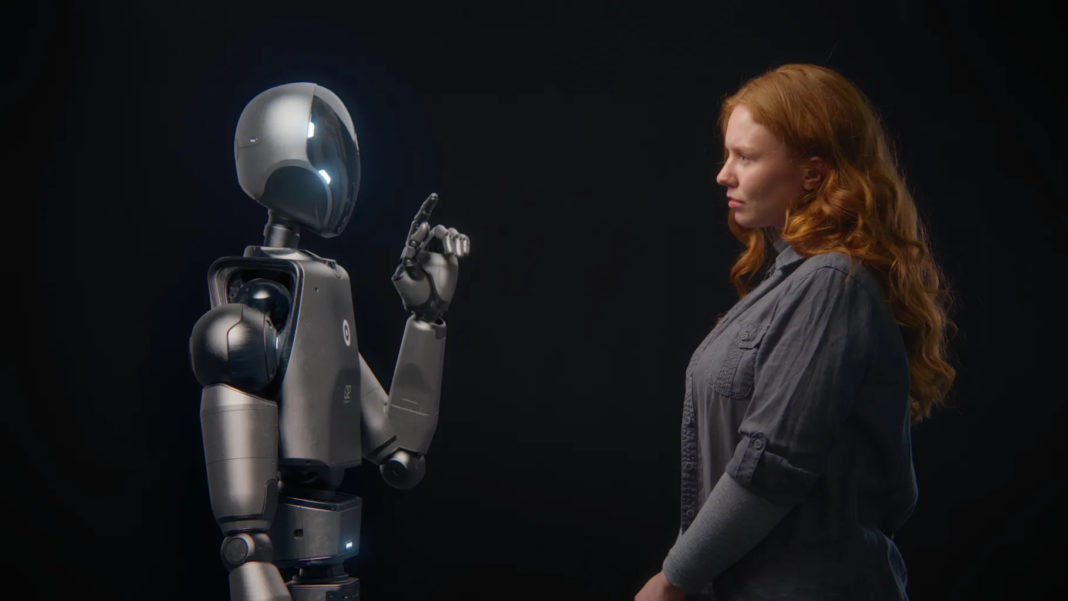

A principios de este año se publicó una noticia especialmente llamativa: un artículo que describía cómo un LLM había superado el test de Turing, un experimento ideado en la década de 1950 por el pionero de la informática Alan Turing para determinar si la inteligencia artificial podía distinguirse de la humana. El LLM en cuestión era ChatGPT 4.5, y el artículo revelaba que había logrado engañar a la gente haciéndole creer que era humano: En un experimento en el que se pidió a los participantes que eligieran si el chatbot o un humano real era la persona auténtica, casi tres de cada cuatro eligieron el primero.

Esto suena… significativo. Pero, ¿cómo, exactamente? ¿Qué significa todo esto?

Qué es el test de Turing y qué no es

Para responder a esa pregunta, primero debemos analizar qué es el test de Turing y qué significa para un LLM aprobarlo o reprobarlo.

Cameron Jones, estudiante de posdoctorado en la Universidad de California en San Diego y uno de los coautores del nuevo artículo, explica que Turing introdujo la idea de la prueba en su influyente artículo de 1950 «Computing Machinery and Intelligence» (Máquinas computacionales e inteligencia). El artículo se proponía abordar una gran pregunta fundamental que ocupaba las mentes de los contemporáneos de Turing: «¿Pueden pensar las máquinas?».

En su artículo, Turing rechaza rápidamente la pregunta por considerarla ambigua y poco rigurosa, ya que no queda claro qué es una «máquina» en este contexto, ni qué es «pensar». Argumenta que se necesita una pregunta más matizada y fácil de abordar, y propone: «¿Puede una máquina actuar de tal manera que sus acciones sean indistinguibles de las de un humano?». Para responder a esta pregunta, propone lo que él denomina «el juego de la imitación», y es este ejercicio el que desde entonces se conoce simplemente como «la prueba de Turing».

La prueba consiste en que una persona, el «interrogador», se comunique simultáneamente con dos interlocutores ocultos, denominados «testigos». Toda la comunicación es escrita. La particularidad es que, mientras que uno de estos testigos es una persona real, el otro es una máquina. El objetivo del juego, explica Jones, «es que el interrogador averigüe cuál de los dos testigos es el humano real».

Jones y su equipo realizaron este experimento con cuatro LLM. ChatGPT 4.5 fue, con diferencia, el más exitoso: el 73 % de los participantes lo identificaron como un humano real. Otro modelo con el complicado nombre de LLaMa-3.1-405B fue identificado como humano en el 56 % de los casos. (Los otros dos modelos, ELIZA y GPT-4o, lograron tasas de éxito del 23 % y el 21 %, respectivamente, y no se volverá a hablar de ellos).

¿Qué significa que ChatGPT haya superado la prueba de Turing?

Los resultados de ChatGPT 4.5 y LLaMa son bastante sorprendentes, pero la pregunta realmente interesante es qué significa su éxito.

Es importante señalar desde el principio que la prueba no está diseñada para detectar la inteligencia artificial. Al rechazar la pregunta «¿Pueden pensar las máquinas?», Turing también elude hábilmente la espinosa cuestión de quién es exactamente el que piensa si la respuesta es «sí». Consideremos la famosa afirmación de René Descartes cogito, ergo sum, «pienso, luego existo», que esencialmente exige que la presencia del pensamiento requiera conciencia.

Sin embargo, el artículo de Turing sostiene que el éxito en el juego de la imitación significa que no podemos negar la posibilidad de que exista una inteligencia artificial genuina. Como explica Jones, Turing «básicamente [argumentó] que si pudiéramos construir una máquina tan buena en este juego que no pudiéramos distinguir de forma fiable la diferencia entre los testigos, entonces, en esencia, tendríamos que decir que esa máquina era inteligente».

Los lectores modernos podrían rechazar tal valoración, por lo que vale la pena analizar el razonamiento de Turing, que era el siguiente:

- No podemos saber si nuestros semejantes son inteligentes. No podemos habitar sus mentes ni ver a través de sus ojos.

- Sin embargo, los aceptamos como inteligentes.

- ¿Cómo llegamos a esta conclusión? Turing sostiene que lo hacemos basándonos en el comportamiento de nuestros semejantes.

- Si atribuimos inteligencia basándonos en el comportamiento y nos encontramos con una situación en la que no podemos distinguir entre el comportamiento de una máquina y el de un humano, deberíamos estar preparados para concluir que el comportamiento de la máquina también indica inteligencia.

Una vez más, los lectores podrían argumentar que esto no es correcto. Y, de hecho, la cuestión clave radica en la premisa de Turing de que atribuimos inteligencia basándonos únicamente en el comportamiento. Abordaremos los contraargumentos a su debido tiempo, pero primero vale la pena pensar en qué tipo de comportamiento nos parece que transmite inteligencia.

Por qué Turing eligió el lenguaje como prueba para las máquinas

Parece que no fue casualidad que Turing eligiera el lenguaje como base para llevar a cabo su «juego de imitación». Al fin y al cabo, hay muchas formas obvias en las que una máquina nunca podría imitar a un humano y, del mismo modo, hay muchas formas en las que una persona nunca podría imitar a una máquina. Sin embargo, el lenguaje impreso es simplemente un conjunto de letras en una página. No dice nada sobre si fue producido por un humano con una máquina de escribir o por una computadora con una impresora.

No obstante, la simple presencia del lenguaje conlleva toda una serie de suposiciones. Desde que nuestros antepasados comenzaron a construir frases, el lenguaje ha sido, al menos por lo que sabemos, dominio exclusivo de la humanidad (aunque algunos simios se están acercando).

Lo mismo ocurre con el tipo de inteligencia que poseemos: otros animales son inteligentes, pero ninguno de ellos parece pensar como nosotros ni poseer el grado de autoconciencia que demuestran los humanos. Sobre esta base, es casi imposible no confundir el lenguaje con la inteligencia. Esto, a su vez, hace que sea muy difícil no atribuir instintivamente cierto grado de inteligencia a cualquier cosa que parezca estar hablando con nosotros.

Este punto fue planteado de manera elocuente en un ensayo reciente de Rusty Foster, autor del boletín informativo Today in Tabs, que lleva mucho tiempo publicándose. Foster sostiene que tendemos a confundir el lenguaje con la inteligencia porque, hasta ahora, la presencia del primero siempre ha indicado la presencia de la segunda. « El problema esencial es el siguiente: el software de lenguaje generativo es muy bueno para producir cadenas de lenguaje largas y contextualizadas, y la humanidad nunca antes había experimentado un lenguaje coherente sin ningún tipo de cognición que lo impulsara», escribe Foster. «En la vida cotidiana, nunca se nos ha exigido distinguir entre «lenguaje» y «pensamiento», porque solo el pensamiento era capaz de producir lenguaje».

Foster hace una excepción con los ejemplos «triviales», pero incluso estos nos resultan sorprendentemente convincentes. Pensemos, por ejemplo, en un loro. Sin duda, resulta desconcertante oír a un pájaro hablar de repente en nuestro idioma, pero, lo que es más importante, también es casi imposible no responderle. (Los espectadores tolerantes con el lenguaje soez pueden disfrutar de este ejemplo, en el que una mujer muy australiana discute con un loro muy australiano sobre los méritos intelectuales del perro de la familia). Aunque sabemos que los loros no saben realmente lo que están «diciendo», la presencia del lenguaje exige una respuesta en lenguaje. Entonces, ¿qué pasa con los LLM? ¿Son esencialmente loros hambrientos de energía?

«Creo que [esta ha sido] una de las principales críticas» al test de Turing, afirma Jones. «Es una perspectiva muy conductista sobre lo que es la inteligencia: que ser inteligente es mostrar un comportamiento inteligente. Por lo tanto, es posible que se quieran establecer otras condiciones: se podría exigir que una máquina mostrara el comportamiento adecuado o que tuviera el historial adecuado de interacción con el mundo».

El experimento mental de la habitación china

También hay experimentos mentales que cuestionan las suposiciones de la prueba de Turing sobre la imposibilidad de distinguir entre la apariencia de inteligencia y la presencia de inteligencia genuina. Jones cita el experimento mental de la habitación china de John Searle, presentado en un artículo publicado en 1980, como quizás el más conocido de ellos. En el artículo, Searle se imagina a sí mismo en una habitación en la que alguien le pasa trozos de papel por debajo de la puerta. Estos trozos de papel tienen caracteres chinos. Searle no habla chino, pero se le ha proporcionado un libro con instrucciones detalladas sobre cómo dibujar caracteres chinos y un conjunto de instrucciones sobre qué caracteres proporcionar en respuesta a los que recibe por debajo de la puerta.

Para una persona ajena a la situación, podría parecer que Searle habla chino perfectamente, cuando en realidad solo está siguiendo unas instrucciones —un programa— que le indican qué caracteres dibujar y cómo hacerlo. Como explica Searle en su artículo: «Me parece bastante obvio en el ejemplo que no entiendo ni una palabra de las historias chinas». Tengo entradas y salidas que son indistinguibles de las de un hablante nativo de chino, y puedo tener cualquier programa formal que se desee, pero sigo sin entender nada».

Este argumento es un rechazo explícito de la premisa de la prueba de Turing. Con él, Searle propone una distinción crucial entre entender y aparentar entender, entre pensar y aparentar pensar.

Modificar ChatGPT para engañar a la gente

Esto también pone de manifiesto otro posible problema del test de Turing: la habitación china está claramente diseñada con el propósito expreso de engañar a la persona que se encuentra al otro lado de la puerta o, dicho de otro modo, es un programa diseñado específicamente para superar el test de Turing. Teniendo esto en cuenta, cabe señalar que, en el experimento de Jones, los LLM que superaron la prueba requirieron cierto grado de ajuste y puesta a punto para resultar convincentes. Jones afirma que su equipo probó un gran número de indicaciones para el chatbot, y uno de los principales retos fue «conseguir que [el modelo] no hiciera cosas que hace ChatGPT».

Algunas de las formas en que Jones y su equipo lograron que ChatGPT no sonara como ChatGPT son sin duda fascinantes y, una vez más, giran en torno a los matices del lenguaje. «No quieres que siempre hable con oraciones completas», dice Jones. «Hay una forma informal en la que la gente habla cuando envía mensajes de texto, es como fragmentos de oraciones. Necesitas incorporar ese tipo de cosas».

Además, el equipo experimentó con ChatGPT cometiendo errores ortográficos para que sonara más humano. Los errores tipográficos son «en realidad bastante difíciles de conseguir. Si le dices a un LLM que se esfuerce por cometer errores ortográficos, lo hace en cada palabra, y los errores son realmente poco convincentes. No creo que tengan un buen modelo de cómo es una sustitución de teclado, en la que pulsas la tecla equivocada en una palabra».

Por qué ChatGPT es mejor que otros LLM

Los LLM son temas difíciles de investigar: por su propia naturaleza, su funcionamiento interno es fundamentalmente inescrutable. Incluso los aspectos de su construcción que pueden estudiarse suelen estar ocultos tras acuerdos de confidencialidad y capas de secreto corporativo. No obstante, según Jones, el experimento reveló algunas cosas sobre qué tipo de LLM está mejor equipado para realizar una imitación creíble de un humano: «Se rumorea que ChatGPT 4.5 es uno de los modelos más grandes, y creo que ser un modelo grande es realmente útil».

¿Qué significa «grande» en este sentido? ¿Una gran base de código? ¿Un gran conjunto de datos? No, dice Jones. Explica que un modelo grande tiene un número relativamente grande de variables internas cuyos valores se pueden ajustar a medida que el modelo recopila datos de entrenamiento. «Una de las cosas que se observa es que los modelos destilados más pequeños a menudo pueden imitar un buen rendimiento en matemáticas, e incluso en razonamientos bastante simples. Pero creo que son los modelos realmente grandes los que tienden a tener buenas habilidades sociales y de comportamiento interpersonal».

¿Predijo Turing la existencia de ChatGPT?

¿Alguna vez Turing concibió su prueba como algo que realmente se llevaría a cabo? ¿O se trataba más bien de un experimento mental? Jones afirma que la respuesta a esa pregunta sigue siendo objeto de debate entre los estudiosos de Turing. Por su parte, Jones dice que «solo se basa en el propio artículo. Creo que se puede leer el artículo de forma bastante literal, como una sugerencia de que la gente podría llevar a cabo este experimento en algún momento en el futuro».

Dicho esto, Jones también señala: «Creo que está claro que Turing no está estableciendo una metodología. Quiero decir, creo que no imagina que valga la pena realizar este experimento durante décadas. Por lo tanto, no dice cuánto tiempo debe durar ni si hay reglas y de qué pueden hablar».

Si Turing previó que la prueba podría ser superable, sin duda sabía que no ocurriría en la década de 1950. No obstante, su artículo deja claro que al menos imaginó la posibilidad de que algún día pudiéramos construir máquinas que lo lograran: «No nos preguntamos si todas las computadoras digitales lo harían bien en el juego ni si las computadoras disponibles en la actualidad lo harían bien, sino si hay computadoras imaginables que lo harían bien», escribe.

A menudo se ha descrito a Turing, con razón, como un visionario, pero hay un pasaje en el artículo de 1950 que resulta realmente sorprendente por su clarividencia. «Creo que dentro de unos 50 años será posible programar computadoras… para que jueguen tan bien al juego de la imitación que un interrogador medio no tendrá más de un 70 % de posibilidades de identificarlas correctamente tras cinco minutos de preguntas».

Han hecho falta 75 años, no 50, pero aquí estamos, frente a una computadora —o, al menos, un modelo controlado por una computadora— que realmente engaña a las personas el 70 % de las veces.

¿Qué es lo que hace que la inteligencia humana sea única, después de todo?

Todo esto nos lleva de vuelta a la pregunta original: ¿qué significa todo esto? «Esa es una pregunta con la que todavía estoy luchando», dice Jones riendo.

«Una línea de pensamiento que me parece útil es que la prueba de Turing no es una prueba necesaria ni suficiente para determinar la inteligencia: se puede imaginar algo inteligente que no la supere porque no utilice el argot adecuado, y también se puede imaginar algo que la supere y que no sea inteligente».

En última instancia, afirma, la conclusión clave es exactamente lo que dice: «Es una prueba de que estos modelos están llegando a ser capaces de imitar el comportamiento humano tan bien que las personas no pueden notar la diferencia». Esto, evidentemente, tiene todo tipo de implicaciones sociales, muchas de las cuales parecen interesar al público y a la comunidad científica mucho más que a las empresas que fabrican LLM.

También se plantean otras cuestiones filosóficas. Turing aborda varias de ellas en su artículo, sobre todo lo que él denomina el «argumento de la conciencia». Aunque una máquina sea inteligente, ¿es consciente? Turing utiliza el ejemplo de una conversación hipotética entre una persona y una máquina que escribe sonetos, una conversación que se parece mucho al tipo de conversación que se puede tener hoy en día con ChatGPT. La conversación ofrece un ejemplo de algo que podría examinarse «para descubrir si [su autor] realmente entiende [un tema] o si lo ha «aprendido como un loro»».

Por supuesto, hay muchas más cuestiones filosóficas en juego aquí. Quizás la más inquietante sea esta: si rechazamos la prueba de Turing como método fiable para detectar la inteligencia artificial genuina, ¿tenemos alguna alternativa? O, en otras palabras, ¿tenemos algún método fiable para saber cuándo (o si) una máquina podría poseer inteligencia genuina?

«Creo que la mayoría de la gente diría que nuestros criterios para la conciencia [deberían] ir más allá del comportamiento», afirma Jones. «Podemos imaginar algo que produzca el mismo comportamiento que una entidad consciente, pero sin tener la experiencia consciente. Por lo tanto, tal vez queramos tener criterios adicionales».

Aún queda por determinar cuáles deberían ser esos criterios, o incluso si existen criterios fiables para una prueba definitiva que permita determinar si una entidad es inteligente o no. Al fin y al cabo, ni siquiera está claro que tengamos esos criterios para una prueba similar con animales. Como seres humanos, tenemos la certeza inquebrantable de que somos únicos de alguna manera, pero a lo largo de los años, una tras otra, las características que antes considerábamos exclusivamente humanas han resultado no serlo. Algunos ejemplos son el uso de herramientas, la construcción de sociedades y la experiencia de la empatía.

Y, sin embargo, es difícil renunciar a la idea de que somos diferentes. Es sorprendentemente difícil identificar con precisión en qué consiste esa diferencia. Del mismo modo, resulta extremadamente difícil determinar dónde comienza esa diferencia. ¿En qué momento dejamos de ser sacos de electrolitos y comenzamos a ser seres conscientes? Resulta que esta pregunta no es más fácil de responder que la de dónde puede surgir la conciencia a partir del desconcertante caos de señales eléctricas en las CPU de nuestras computadoras.

Turing, siendo Turing, también tenía una respuesta para esto. «No quiero dar la impresión de que creo que la conciencia no es un misterio. Por ejemplo, hay una especie de paradoja relacionada con cualquier intento de localizarla». Sin embargo, argumentó que no era necesario comprender el origen de la conciencia humana para responder a la pregunta planteada por la prueba.

En el sentido más estricto, tenía razón: en sí misma, la pregunta de si una máquina puede imitar de forma fiable a un humano no dice nada sobre la conciencia. Pero la gran publicidad que ha suscitado el hecho de que ChatGPT haya superado el test de Turing dice mucho sobre la época en la que vivimos: una época en la que puede ser muy importante saber si es posible la inteligencia artificial genuina.

Para comprender si una máquina puede ser inteligente, tal vez primero debamos entender cómo y de dónde surge la inteligencia en los seres vivos. Eso podría ayudarnos a comprender si tal surgimiento es posible en las computadoras, o si lo mejor que podemos hacer es crear programas que imiten de manera muy convincente lo que encontramos en Internet, con todos sus sesgos y prejuicios.

Tom Hawking