José Luis Antunez, el presidente de Nucleoeléctrica Argentina, doctor Honoris Causa de la Universidad de Buenos Aires

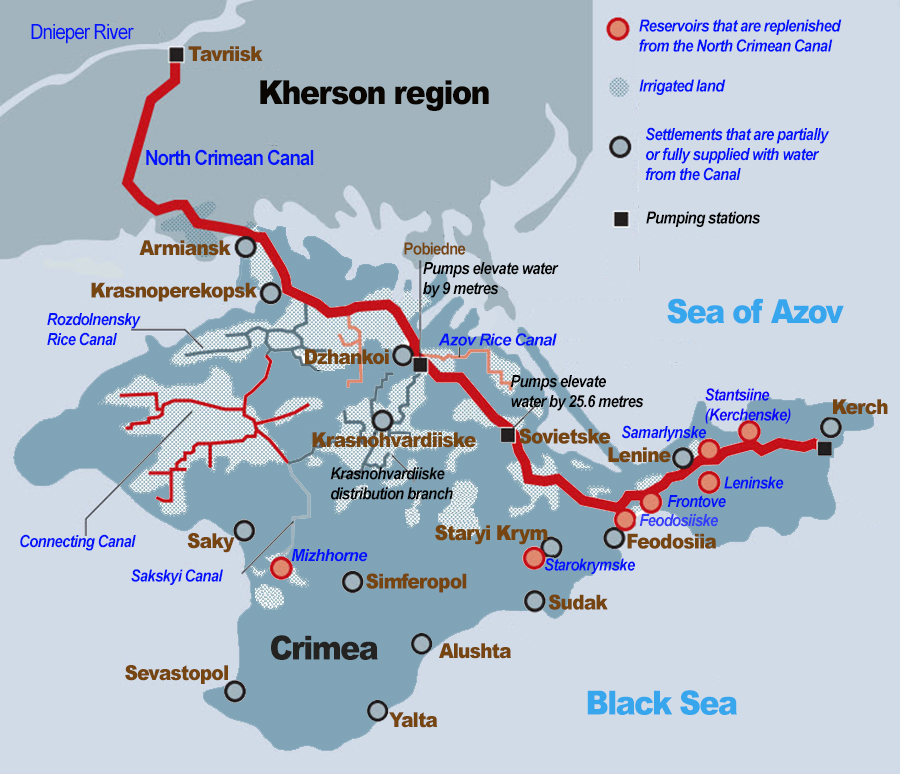

El que voló la represa de Nova Kajovka no es del pago

Daniel E. Arias

COMENTARIO DE AGENDAR:

La conclusión a la que llega Arias -que, frente a los gravísimos daños que ha provocado y provocará la destrucción de la represa a rusos y ucranianos, y a los clientes del cereal de Ucrania – el probable autor intelectual del bombardeo ha sido Estados Unidos- es plausible. Pero cabe recordar que tácticas de «tierra arrasada» han sido usadas en muchísimas guerras -en nuestra historia, Belgrano acudió a ella cuando dispuso el Éxodo Jujeño. Y en esas mismas llanuras donde hoy transcurre esta guerra, esas tácticas han sido usadas una y otra vez, en las historias entrelazadas de Rusia y Ucrania.Abel B. Fernández

Suecia decide favorecer la educación con libros de papel por sobre las pantallas

Suecia canceló su plan de educación digital y financiará la distribución de libros físicos. Detrás de esta decisión está una pregunta que todos pensamos desde la aparición de los kindles, las tablets y los miles de pdf para estudiantes: ¿qué cambia entre la lectura en pantalla y en papel?

Gran Bretaña rechaza la participación de la Fuerza Aérea Argentina en el festival aéreo RIAT 2023

Según fuera informado mediante un breve comunicado oficial de la organización del Royal International Air Tattoo (RIAT 2023), la Fuerza Aérea Argentina (FAA) no participará del festival a desarrollarse los días 14 al 16 de julio en la Base Aérea Fairford en el Reino Unido. El sitio oficial del airshow anunció que “el Boeing 737 argentino previamente anunciado ya no participara en el Royal International Air Tattoo 2023”.

La presencia de la FAA había sido confirmada con la participación del Boeing 737-700 T-99 “Islas Malvinas” semanas atrás, lo cual resultó llamativo dado que luego de Guerra de Malvinas en 1982, la FAA no participo del RIAT. Según el sitio británico gloucestershie.co.uk, al denominación del T-99 habría generado malestar en asociaciones de veteranos del conflicto que enfrento a ambos países en 1982, pese a haber sido aprobada su presencia por el Ministerio de Defensa del Reino Unido y la Royal Air Force previamente.

El “Islas Malvinas” tenia prevista su exhibición estática en plataforma durante el evento, considerando que se trata de un avión de transporte sin capacidad para desempeñarse en misiones especificas. En la ultima participación de la FAA, en 1981, el KC-130 TC-70 fue afectado al RIAT, recibiendo junto a su tripulación el primer puesto en la competencia de búsqueda y rescate mediante la distinción “Best non ASW crew”. Este galardón tuvo un gran valor ya que el TC-70 compitió contra medios especializados en lucha antisubmarina y SAR marítimo.

Hasta el momento, desde medios británicos, indicaron que ni desde la Royal Air Force (RAF) ni la Fuerza Aérea Argentina emitieron comentarios al respecto o un comunicado oficial.

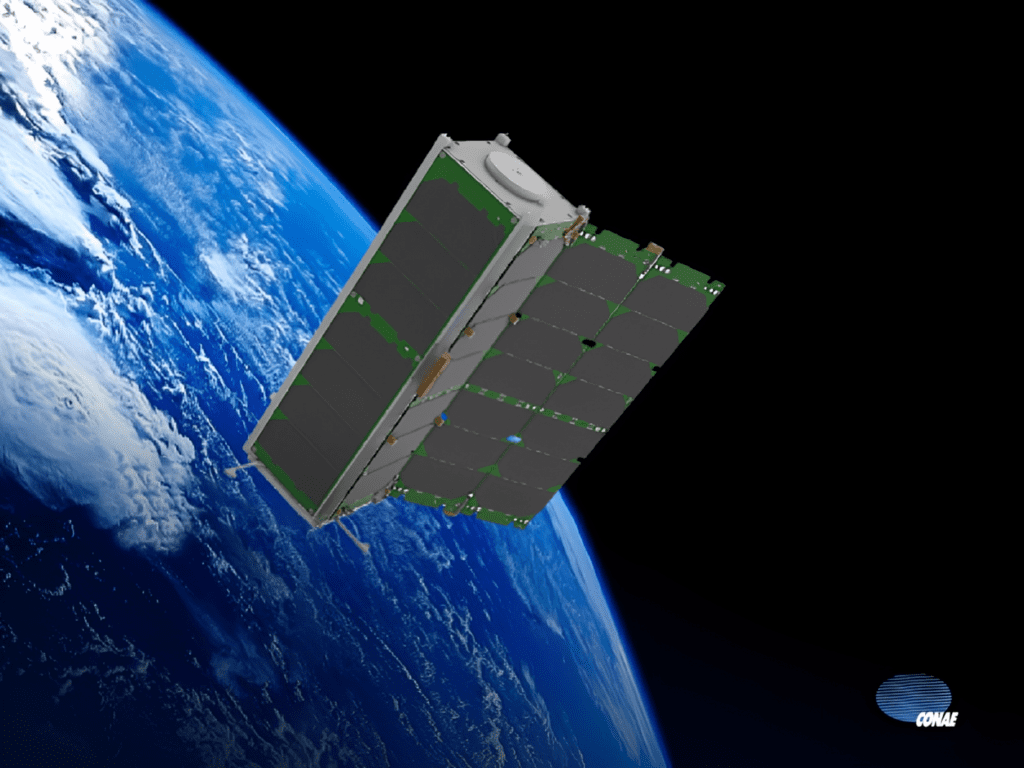

Noticias sobre la presencia de Argentina en el espacio: SAOCOM y ALOFT

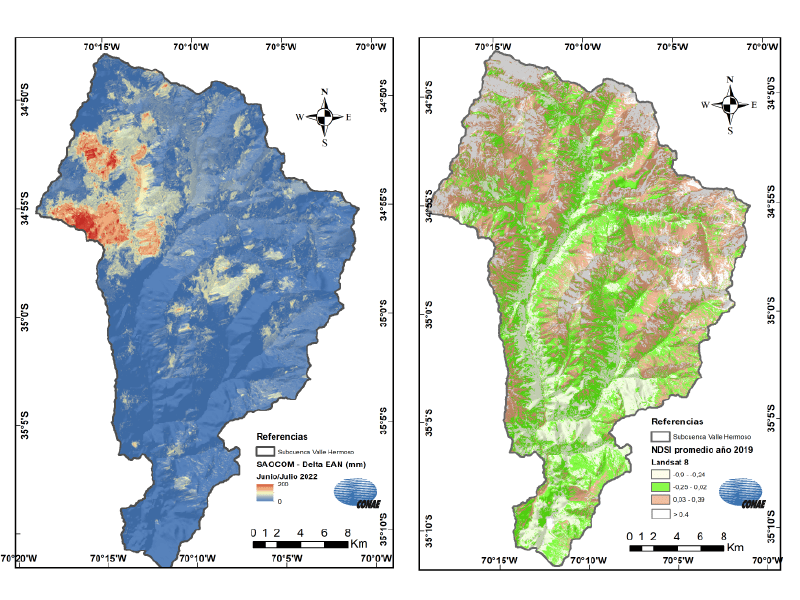

Buscando agua

Los satélites SAOCOM entraron en acción ya que la CONAE confirmó que los satélites podían proveer información clave para el caso. “Aportamos a este convenio todas las bases de datos satelitales que tiene la CONAE, con un fuerte énfasis en los datos de la constelación SAOCOM 1, para analizar variables que asistan al monitoreo de la cuenca, como el equivalente en agua de nieve y el momento en el cual la nieve empieza a fusionarse, ya pudimos reconstruir escenarios de información histórica”, explicó Romina Solorza, de la Gerencia de Observación de la Tierra de la CONAE.

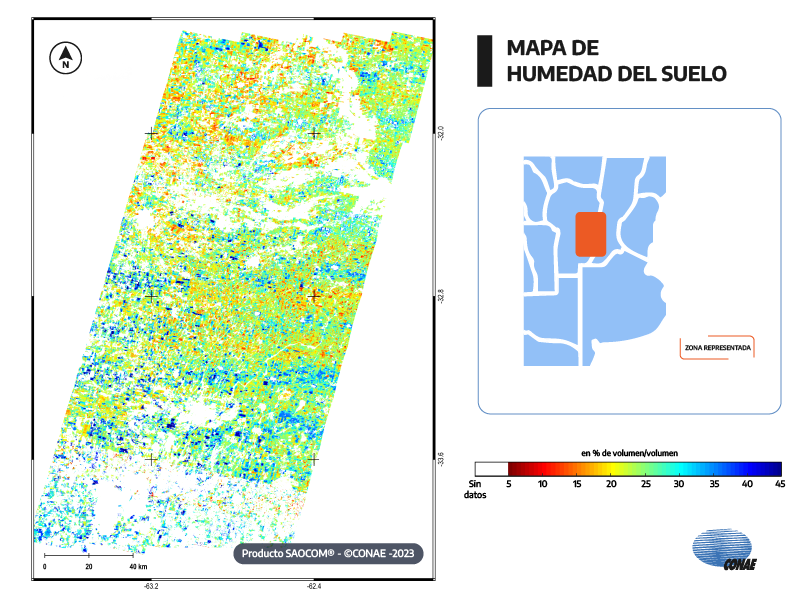

Al servicio del sector agrícola

Frulla comentó que el foco de la SAOCOM está en el sector agropecuario. Se utilizan los datos que aportan para predecir los cultivos y cuánto van a rendir. “Se generan mapas de humedad de suelo, que son los objetivos de emisión. Y a partir de estos mapas, se generan mapas de pronóstico de fusariosis en el trigo, estimación de rinde de los principales cultivos de nuestro país, tales como soja, maíz, trigo y girasol, eso principalmente en la región pampeana, aunque también se puede generar fuera de la región pampeana, pero la región pampeana es la zona en la que se cultiva por excelencia este tipo de cultivos”, explicó. Los satélites SAOCOM cuentan con dos misiones, el 1A, lanzado al espacio en 2018, y el 1B, lanzado en 2020. Se encuentran equipados con un Radar de Apertura Sintética (SAR) en banda L, desarrollado en la Argentina, único en el mundo, y que se destaca por obtener información de día y de noche, e independientemente de las condiciones meteorológicas.

Los minisatélites

El proyecto Autonomous LEO Formation Flying Technology (ALOFT), es una misión satelital de CONAE conformada por Cube-Sats, dos nanosatélites casi idénticos, con los cuales busca experimentar y validar tecnologías de vuelo en formación y comunicación Inter satelital.

Llega la carne hecha en laboratorio ¿Se van los feedlots?

Comentario de AgendAR:

Hay dos unidades métricas que tiene que sobrepasar esta industria, medibles contra kilo de producto generado hipotéticamente imposible de distinguir de una carne homóloga de origen animal. Una es el costo total de producción en moneda firme, y la otra, el costo en carbono añadido a la atmósfera. Hay un tercer baremo: la comparación de contaminantes del agua y el suelo generados en cada caso. Por ahora, creo que el kilo de lomo producido a campo en Argentina va a seguir siendo más barato y de menor impacto ambiental que cualquier ersatz de bioingenería. Es más, la ganadería Voisin o Savory construye suelo fértil, es decir saca CO2 del aire y lo fija al terreno. Singapur podría alguna vez alimentar con carne artificial a los chinos pobres, pero creo que el negocio aquí va a ser darle carne en serio a los chinos ricos. Lo que va a morir aquí es el feedlot.Daniel E. Arias

La clovibactina elimina eficazmente las superbacterias; un nuevo fármaco proporciona la clave contra la resistencia a los antibióticos

La resistencia a los antibióticos como nueva crisis médica

En 1928, el bacteriólogo escocés Alexander Fleming descubrió accidentalmente la penicilina en el Hospital St. Mary de Londres. Este descubrimiento condujo al desarrollo de los antibióticos, que ayudaron a reducir el número de muertes debidas a infecciones bacterianas. En casi 100 años, los antibióticos han cambiado el curso de la medicina y han ayudado a prolongar la vida humana una media de 23 años.

Sin embargo, el uso excesivo e irresponsable de este medicamento ha provocado resistencia a los antibióticos entre las bacterias. Sólo en Estados Unidos se registran más de 2,8 millones de infecciones por resistencia a los antibióticos, lo que provoca 35.000 muertes al año. Es normal que las bacterias desarrollen resistencia a un fármaco, pero la forma en que se utilizan los medicamentos puede afectar a la tasa y el grado de esta resistencia. La resistencia a los antibióticos se produce cuando microorganismos como bacterias y hongos desarrollan la capacidad de resistir a los fármacos diseñados para matarlos. Esto significa que no mueren y siguen creciendo. Si los antibióticos pierden su eficacia, también perderemos la capacidad de tratar infecciones que antes eran manejables. Hoy en día, la resistencia a los antibióticos se considera una amenaza mundial urgente para la salud pública. Puede afectar no sólo a la salud humana, sino también a otros sectores, como la veterinaria y la agricultura.Comentario de AgendAR:

El gigante automotriz Stellantis desembarca en el negocio de energías renovables en Argentina

Argentina y Brasil

El ingreso a 360 Energy posicionará a la automotriz en el sector renovable en la Argentina, donde tiene una planta de producción en Córdoba y otra en El Palomar (Buenos Aires). Además, 360 Energy y Stellantis planean ingresar a la generación renovable en Brasil, donde la automotriz también tiene fabricas de vehículos. La idea sería construir una planta solar de 65 MW vinculada a las fábricas de autos en los estados de Pernambuco y Minas Gerais. Stellantis lideró las ventas del sector automotriz en el primer trimestre del año en la Argentina con 36.000 unidades vendidas, que representa el 31,8% del mercado local. En producción, Stellantis también lidera el mercado argentino con un crecimiento interanual de 36,4% (más de 40.000 unidades) en comparación a los primeros tres meses de 2022.Cobre y electrificación

Como parte de la agenda de electrificación, la multinacional Stellantis ya había desembarcado en febrero en el sector minero en el país con la adquisición por US$ 155 millones del 14,2% de la compañía canadiense McEwen Copper, que lleva adelante el megaproyecto de cobre Los Azules en la provincia de San Juan. Según la consultora canadiense Mining Intelligence, está dentro de las 10 principales minas de cobre sin explotar del mundo. El objetivo de Stellantis es asegurarse el abastecimiento de cobre para acelerar la electrificación y liderar la industria automotriz con un compromiso de ser carbono neutral para 2038, según aseguró en un comunicado difundido en febrero Carlos Tavares, CEO global de la multinacional.«La crisis del cambio climático no se puede pensar sin analizar la inequidad»

El Sol todavía no había salido en Argentina cuando la Organización Meteorológica Mundial publicó el anuncio en sus redes sociales: “Prof. Celeste Saulo es elegida nueva Secretaria General de la OMM”. La votación acababa de terminar en un auditorio en Ginebra, Suiza. Y fue histórica. Los representantes de 193 países acababan de elegir, por primera vez en la historia, a una mujer para ocupar el mayor cargo en la OMM.

Pocos minutos después, «Celeste Saulo», «secretaria general» y «OMM» se convirtieron en tendencia. Y luego aparecieron los videos desde el interior del recinto, donde ella misma celebra, aplaude y arenga cuan gol mundialista. Y no es para menos. Su logro es un logro nacional, latinoamericano, pero más de que nada, de género. Saulo es doctora en ciencias de la atmósfera, egresada de la Universidad de Buenos Aires, “hija de la educación pública, que le dio las oportunidades”, como ella ha destacado tantas veces. Hoy tiene 59 años, está casada y tiene 2 hijos. Luego de encabezar el Centro de Investigaciones del Mar y la Atmósfera, de ser profesora titular en la Facultad de Ciencias Exactas y Naturales de la UBA y de investigar en el CONICET, en 2014 hizo historia al convertirse en la primera directora mujer del Servicio Meteorológico Nacional (SMN), organismo que aún preside. Allí, en la sede central del SMN, en el barrio porteño de Palermo, Saulo tiene su oficina, equipada como cualquier otra: escritorio, mesa de reuniones, reconocimientos a su trayectoria profesional. Pero un detalle llama la atención en las paredes. Dos mapas. Uno, es Argentina “invertida”, con Ushuaia y Antártida en el «norte» y Chaco al «sur». El otro, un planisferio centrado en nuestro país. Ambas piezas bien pueden ser indicios de su forma de pensar el mundo, y reivindicar la mirada del sur global.

– Sí, efectivamente ese planisferio habla de cómo pienso el mundo y cómo pienso las crisis que atraviesa. Para mí la crisis del cambio climático no se puede pensar sin analizar la inequidad, que también sigue aumentando de manera exponencial. Viniendo de un país en desarrollo, el trabajo tiene que ver con la inclusión, con la diversidad, con trabajar con los servicios meteorológicos e hidrológicos de los países en desarrollo, de los pequeños estados insulares, los países menos desarrollados, entendiendo que no solo es necesario ayudarlos a fortalecerse sino que también es importante empoderarlos, construir y codiseñar las soluciones.

– En la agenda global hay un tema fundamental que es la alerta temprana para todas las personas. El Congreso (de la OMM) decidió que es un tema prioritario. Yo coincido con esa prioridad, pero luego de la experiencia en el Servicio Meteorológico Nacional, sabemos que una iniciativa así requiere el trabajo codo a codo a nivel de territorio. Que no es simplemente una aplicación o un modelo basado en inteligencia artificial lo que nos va llevar a resolver el problema del alerta temprana, sino entender que es un problema mucho más complejo, que tiene que ver con la percepción del riesgo, con el conocimiento del riesgo, con cómo las culturas y las comunidades reaccionan frente a los alertas. En fin, hay un trabajo enorme y ahí es donde vamos a tratar de hacer fuerza en esta gestión.

– Es un llamado a preguntarse qué pasó hasta este momento. La OMM tiene 150 años, con un dominio centrado en Europa, de donde provinieron la mayoría de los secretarios generales, excepto uno. Mi llegada va a traer una mirada más diversa, del sur global, que es una mirada que estaba faltando. No me planteo solo una agenda de género, sino una agenda de inclusión, donde se tengan en cuenta distintas miradas. Por ejemplo, hoy en nuestra disciplina se habla de los saberes ancestrales. Es decir, del valor que hay en esos saberes, que, a mi juicio, hoy están subvalorados. Es mi objetivo ponerlas en valor junto con la mirada de género.

Creo que un desafío grande fue ordenarlo en el sentido administrativo y procedimental. También, empoderar a trabajadores y trabajadoras para que realmente se apropiaran de un proyecto común, de un horizonte compartido. De la importancia que tiene el organismo y del rol de cada uno en ese proyecto. Jerarquizar al SMN fue muy importante también. Y armar equipos más transversales para trabajar en torno a un plan estratégico del que todos se sintieran parte, para saber hacia dónde ir y qué esperar.

El otro gran desafío ha sido articular mejor con la academia, que era un mandato imprescindible. Había buena predisposición para hacerlo pero no estaban los canales adecuados y pienso que lo hemos logrado. Crear una estructura (orgánica) que superara una estructura básica, que en sí misma todavía hoy resulta insuficiente pero que, sin embargo, nos permitió organizar más y mejor al Organismo; que las expectativas estuvieran acordes a algunos cargos directivos que hoy existen.

– Mejorar toda la cadena de valor. Como pendiente todavía queda fortalecer la red de observación, pero pudimos ordenar las estaciones meteorológicas, atender las necesidades y las prioridades. Fortalecimos mucho la generación de información, la producción de pronósticos, la coordinación y puesta en marcha de nuevos modelos de pronóstico y del sistema que hay detrás el nuevo Sistema de Alerta Temprana.

También trabajamos muchísimo la comunicación, tanto con el público en general como con distintos sectores usuarios. Todos estos fueron enormes desafíos porque no estaban en la carpeta del SMN que yo encontré, y que sin embargo hoy se han hecho parte de nuestro sentimiento en cuanto a qué SMN queremos.

– Creo que lo importante es llevar la pasión y el convencimiento en lo que uno hace a todos los niveles en los que uno trabaja. Toda mi vida trabajé de esa manera y tengo que agradecer tener una familia que bancó ese modo de pensar mi carrera profesional, basada en las convicciones, en las cosas que me gustaban y las cosas en que creía. Eso me dio una fuerza muy grande. Y esa fuerza se nota en la reciprocidad que encontrás cuando la gente ve que trabajas con pasión y con autenticidad, y que realmente querés lo mejor para el conjunto.

– Creo que el mensaje es que los principios son muy importantes; que las pasiones son enormes motores; que tenemos que tener proyectos y aferrarnos a ellos. Y trabajar en red, porque es la red la que en definitiva termina dándote la posibilidad de dar los grandes saltos. Saber que todos tenemos tropiezos, pero eso no es un impedimento, sino que implica simplemente un aprendizaje, un reintentar y un nunca darse por vencida. Ese es el mensaje que me gustaría transmitir, que se suma al del compromiso con las pasiones que uno tiene.

Saulo asumirá su cargo el 1 de enero de 2024, y su mandato se extenderá por cuatro años. Encabezará la definición de la estrategia de los próximos años para enfrentar los desafíos del cambio climático a nivel global.El Vision Pro de Apple es una maravilla técnica. Pero inutil

“Ciertos productos… cambian nuestra forma de ver la tecnología”, dijo Tim Cook, el jefe de Apple, al presentar el 5 de junio el último gadget del gigante tecnológico. El Vision Pro, un auricular para realidad virtual y aumentada (VR y AR en la jerga), cuyo desarrollo se rumorea desde hace años, estará disponible a principios del año que viene. Con más de 5.000 patentes, Apple ha calificado estas elegantes gafas de cristal como “el producto más ambicioso que jamás hayamos creado”.

También es posible que sea uno de los menos vendidos. La empresa esperaba vender unos 3 millones de unidades en el primer año. Pero las expectativas se han reducido; algunos analistas esperan ahora que Apple distribuya menos de 200.000 unidades en 12 meses, un orden de magnitud inferior al de cualquier otro gran lanzamiento de producto. La primera iteración del Vision Pro puede ser un fracaso comercial. Sin embargo, también es el primer paso en el camino hacia algo que Apple espera que sea mucho más grande.

La tecnología, que Apple aún no ha puesto a disposición del público, tiene un aspecto impresionante. A diferencia de otros auriculares, que suelen requerir mandos manuales, el Vision Pro se controla con gestos de la mano, comandos de voz y movimientos oculares. Hace un seguimiento de los ojos como un ratón y reconoce el iris en lugar de una contraseña. Es un dispositivo “de paso”, que utiliza cámaras frontales para mostrar al usuario una vista en vídeo del mundo que le rodea. Y para que parezca más normal a los ojos de los demás, proyecta una imagen de vídeo de sus ojos en la parte frontal del cristal. (Un anuncio de Apple muestra a un hombre preparando el desayuno a sus hijos mientras lo lleva puesto, algo que le costaría hacer con la mayoría de los auriculares).

La principal razón de las bajas ventas previstas es el precio. A 3.499 dólares, el dispositivo es más de tres veces más caro que los auriculares de realidad virtual y realidad aumentada rivales de Meta, el Quest Pro, y más de diez veces más caro que el Quest 2, el dispositivo de realidad virtual de la empresa de medios sociales ampliamente utilizado. Incluso a este precio, el gadget de Apple ha tenido que hacer algunas concesiones técnicas. Tiene una batería externa, conectada a los auriculares mediante un cable, que sólo dura dos horas. Y aunque los diseñadores de Apple han hecho todo lo posible para que sea lo más elegante posible, sigue siendo incómodo ponérselo en la cara.

Estas dificultades han obligado a muchos competidores a replantearse su participación en las realidades virtual y aumentada. Meta parece estar reduciendo su entusiasmo, tras las quejas de los inversores sobre sus gastos y, al parecer, las débiles ventas de la Quest Pro a pesar de una fuerte rebaja de precio desde su lanzamiento en octubre. Microsoft, un gigante del software, ha aparcado la idea de fabricar otras HoloLens, un dispositivo ar que utilizan principalmente clientes corporativos. Snap, otra empresa de redes sociales, no parece tener prisa por sacar una nueva versión de sus ar Spectacles. Tencent, un titán digital chino, abandonó sus planes de hardware de realidad virtual en febrero.

No es raro que los nuevos productos tarden en despegar. La mayoría de los éxitos anteriores de Apple tardaron varios años en calar. Las ventas del Apple Watch fueron bajas hasta que la gente decidió que su uso clave era para controlar su salud. El iPhone no despegó realmente hasta su cuarta generación, en 2010, momento en el que la App Store se llenó de miles de aplicaciones que hicieron que la gente se diera cuenta de lo que el teléfono podía hacer. Descubrir más usos para el iPhone también ayudó a justificar su precio. El dispositivo se consideraba ridículamente caro cuando se lanzó, con un precio de hasta 599 dólares; hoy en día, el modelo superior cuesta 1.599 dólares, un precio que la gente está dispuesta a pagar porque puede hacer muchas cosas. Quizá Apple pueda normalizar de la misma manera el pago de miles de dólares por unas gafas.

Aun así, Vision Pro se lanza en una fase especialmente temprana. Más que un verdadero producto de consumo, se trata de un “costoso kit para desarrolladores”, afirma un fabricante de componentes de ar. Lanzar un producto orientado a los desarrolladores en esta fase es una “nueva frontera” para Apple, afirma George Jijiashvili, de la firma de analistas Omdia.

Hay dos razones por las que Apple quiere sacar el producto antes de tiempo. Una es la presión competitiva, sobre todo de Meta, que a pesar de haberse reducido un poco, se ha lanzado a la contratación y adquisición de personal con el objetivo de hacer realidad el “metaverso”. Además de captar talentos, Meta ha estado reclutando usuarios. Según la empresa de datos Insider Intelligence, cerca del 10% de los estadounidenses utilizan auriculares de realidad virtual al menos una vez al mes. La mayoría de estos equipos los fabrica Meta, que ha estado vendiendo su Quest 2 con pérdidas para conseguir una masa crítica de usuarios. Este otoño lanzará el Quest 3, un dispositivo que será mucho menos capaz que el de Apple pero, a 499 dólares, una perspectiva más realista para la mayoría de los consumidores.

La segunda razón por la que Apple quiere sacar su producto es porque ya tiene la vista puesta en lo que vendrá después. Los expertos en tecnología llevan mucho tiempo especulando con la posibilidad de tener unas gafas de ar tan finas y discretas como unas gafas de sol, momento en el que los auriculares dejarán de ser algo aparatoso para empollones y se convertirán en algo que la gente normal pueda llevar todo el día. Estos dispositivos podrían incluso sustituir al smartphone como próxima gran plataforma tecnológica. “No creo que nadie dude de que el AR es el futuro”, afirma Jitesh Ubrani, de IDC, otra empresa de datos. En su presentación, Apple calificó el Vision Pro como “el comienzo de una plataforma completamente nueva”.

Gafas medio llenas

La estrategia no está exenta de riesgos. Apple tiene fama de lanzar productos perfectos y pulidos. Lanzar un dispositivo de 3.499 dólares con una batería de dos horas de duración podría equivaler a lo que Steve Jobs, el difunto predecesor de Cook, solía caracterizar como una “retirada de marca”.

Tampoco está claro qué hará la gente con sus dispositivos. Hasta ahora, los cascos de realidad virtual se han utilizado sobre todo para jugar: casi el 90% del gasto en contenidos de realidad virtual del año pasado se destinó a juegos, según estimaciones de Omdia. El Quest Pro de Meta no ha logrado entusiasmar a los profesionales con su promesa de videoconferencias en persona y cosas por el estilo. La presentación de Vision Pro de Apple, aunque característicamente hábil, no tenía nada parecido a una “aplicación asesina”. Hay algunas funciones interesantes, como la posibilidad de hacer fotos y vídeos en 3D, lo que convertiría al dispositivo en un “generador de nostalgia”, según Ubrani. Pero la mayoría de los usos sugeridos por Apple para el Vision Pro parecen implicar tratarlo como una especie de escritorio virtual gigante, utilizando ventanas flotantes de chats de Zoom u hojas de cálculo de Excel, o viendo una película en una pantalla virtual gigante. Nada de esto es tan innovador como la propia tecnología.

El CEO de Apple, Tim Cook, habla bajo una imagen de Apple Vision Pro en el Apple Park de Cupertino, California, Estados Unidos, este 5 de junio de 2023 (Reuters)

El CEO de Apple, Tim Cook, habla bajo una imagen de Apple Vision Pro en el Apple Park de Cupertino, California, Estados Unidos, este 5 de junio de 2023 (Reuters)Aun así, Apple disfruta de grandes ventajas sobre sus rivales. Cuenta con una enorme base de usuarios, con 2.000 millones de dispositivos en circulación. En la presentación de Vision Pro se mostró cómo se sincronizan los auriculares con los demás aparatos de Apple: los usuarios pueden hacer videollamadas FaceTime con sus amigos desde sus iPhones o proyectar la pantalla de un portátil MacBook en los auriculares con sólo mirarlos. Las aplicaciones para el iPhone y el iPad serán compatibles con Vision Pro, lo que significa que habrá cientos de miles de aplicaciones disponibles en el momento del lanzamiento, aunque no estén optimizadas para el dispositivo.

La estrategia de Apple también es sencilla: fabricar los mejores auriculares y cobrar a los consumidores mucho dinero por ellos y, presumiblemente, cobrar también a los desarrolladores una parte de los beneficios de sus aplicaciones, como ocurre en la App Store. Aunque la empresa parece centrada en el objetivo final de ar, eso es muy distinto del metaverso centrado en la realidad virtual del que tanto ha hablado Mark Zuckerberg, su jefe.

Apple también cuenta con una marca de confianza entre los consumidores. En una encuesta realizada en 2021, tres veces más personas afirmaron que comprarían unos auriculares de Apple que de la empresa que ocupaba el segundo lugar, Google. Meta quedó sexta. También tiene influencia entre los desarrolladores. Tendrá aplicaciones de Microsoft, Zoom y Webex, y una asociación con Unity. Bob Iger, consejero delegado de Disney y antiguo amigo de Jobs, hizo un cameo sorpresa en la presentación para elogiar la “revolucionaria plataforma” de Apple y mostrar cómo los auriculares podrían permitir al público ver una película de “La guerra de las galaxias” antes de ser transportado en realidad virtual al planeta Tatooine, o ver repeticiones en 3D de un partido de baloncesto en realidad virtual en la cadena deportiva ESPN de Disney. Que Mickey Mouse, o incluso el castillo de Disneyland, aparezcan en el salón. “Acercar Disney a nuestros fans de formas que antes eran imposibles”, como dijo el Sr. Iger, es el tipo de cosa que podría entusiasmar a la gente más que las conferencias virtuales.

Es probable que poca gente pague por el Vision Pro, al menos al principio. Pero Cook, que lo comparó con el lanzamiento del Mac y el iPhone, dijo que era el “comienzo de un viaje”. Es posible que el viaje lleve a algún lugar rentable. Como dice el Sr. Ubrani: “Cuando Apple entra en un mercado, cambia por completo la trayectoria del mismo”.