Escuelas tecnicas: 1.400.000 alumnos y la educación es de nivel mundial

ChatGPT es el producto tecnológico de más rápida adopción de la historia. Y ya afecta el mercado laboral

Central Termoeléctrica Brigadier López, de Santa Fe, se renueva con un ciclo más eficiente y usará gas de Vaca Muerta

China, EE.UU. e India son responsables del 52% de las emisiones de carbono

Identifican cuatro nuevas especies de abejas en la Argentina

- Son originarias de nuestro país, Chile y Uruguay, pertenecen al género Megachile y, hasta el presente, la ciencia desconocía su identidad. Un estudio de la UBA las encontró, identificó y les puso nombres.

- Brindan el importante servicio ecosistémico de polinización.

Y añadió: “En general, los cultivos de la Región Pampeana no dependen de polinizadores, y si dependen de alguno, es de abejas manejadas, como la abeja de la miel. Sin embargo, en San Claudio encontramos otra especie de Megachile que utiliza principalmente polen de leguminosas. La estamos estudiando y creemos que podría llegar a ser una buena polinizadora de alfalfa”.

“En nuestro país, históricamente se usó a Megachile rotundata para ese fin, pero es una especie exótica, y está prohibido importarla. A mi entender, esta prohibición es correcta ya que introducir abejas exóticas es una de las causas por las que disminuye la diversidad de abejas nativas en distintas partes del mundo”, recalcó el investigador.

Entonces, ¿por qué no mejorar las condiciones para que las abejas nativas crezcan?, se preguntó Juan Pablo. “Manejarlas a veces es complejo. Una alternativa para favorecerlas sería poner plantas leguminosas nativas en los bordes de los cultivos para aumentar las poblaciones de insectos silvestres. De esta manera se podría potenciar el servicio ecosistémico de polinización cuando haya alfalfa florecida en los lotes”.

El investigador subrayó que además de incluir plantas silvestres en los bordes de los cultivos, otra práctica para mejorar este servicio sería colocar nidos artificiales para abejas silvestres. Al mejorar las condiciones de nidificación, sus poblaciones podrían aumentar.

“Resumiendo, creo que es clave favorecer el crecimiento en tamaño de las poblaciones silvestres de abejas. Y para eso hay que cambiar la forma de hacer agricultura: implementar rotaciones diversas, enriquecer la flora de los bordes de cultivos —especialmente la nativa— y usar menos pesticidas, entre otras cosas. La cuestión es mejorar la calidad de vida de las abejas y también la nuestra. Me parece que estamos en un momento ‘pivot’, y tenemos que pensar de acá para adelante nuevas y mejores alternativas para todos”, cerró. (Pablo A. Roset / SLT-FAUBA).

Y añadió: “En general, los cultivos de la Región Pampeana no dependen de polinizadores, y si dependen de alguno, es de abejas manejadas, como la abeja de la miel. Sin embargo, en San Claudio encontramos otra especie de Megachile que utiliza principalmente polen de leguminosas. La estamos estudiando y creemos que podría llegar a ser una buena polinizadora de alfalfa”.

“En nuestro país, históricamente se usó a Megachile rotundata para ese fin, pero es una especie exótica, y está prohibido importarla. A mi entender, esta prohibición es correcta ya que introducir abejas exóticas es una de las causas por las que disminuye la diversidad de abejas nativas en distintas partes del mundo”, recalcó el investigador.

Entonces, ¿por qué no mejorar las condiciones para que las abejas nativas crezcan?, se preguntó Juan Pablo. “Manejarlas a veces es complejo. Una alternativa para favorecerlas sería poner plantas leguminosas nativas en los bordes de los cultivos para aumentar las poblaciones de insectos silvestres. De esta manera se podría potenciar el servicio ecosistémico de polinización cuando haya alfalfa florecida en los lotes”.

El investigador subrayó que además de incluir plantas silvestres en los bordes de los cultivos, otra práctica para mejorar este servicio sería colocar nidos artificiales para abejas silvestres. Al mejorar las condiciones de nidificación, sus poblaciones podrían aumentar.

“Resumiendo, creo que es clave favorecer el crecimiento en tamaño de las poblaciones silvestres de abejas. Y para eso hay que cambiar la forma de hacer agricultura: implementar rotaciones diversas, enriquecer la flora de los bordes de cultivos —especialmente la nativa— y usar menos pesticidas, entre otras cosas. La cuestión es mejorar la calidad de vida de las abejas y también la nuestra. Me parece que estamos en un momento ‘pivot’, y tenemos que pensar de acá para adelante nuevas y mejores alternativas para todos”, cerró. (Pablo A. Roset / SLT-FAUBA). Monitoreo automático de la contaminación en la Cuenca Matanza Riachuelo

YPF afirma: la exploración offshore en el Mar Argentino puede ser un «Vaca Muerta II»

Se realizo el Congreso de Pampa Azul en Mar del Plata. Una iniciativa para un pais maritimo y bicontinental

Se canceló en EE.UU. el proyecto NuScale, el competidor más publicitado del CAREM

Regreso atómico

El mes pasado, los funcionarios locales regresaron a sus comunidades tras un retiro de la UAMPS con el mensaje tranquilizador de que el proyecto de Idaho Falls iba por buen camino para conseguir los nuevos patrocinadores que necesitaba, según las reuniones locales revisadas por WIRED. Esto parecía ser una buena noticia en lugares como Los Álamos (Nuevo México), donde esta primavera un funcionario describió el proyecto como un «regreso a casa» de la tecnología atómica. El proyecto debía llegar justo a tiempo para ayudar al condado a cumplir su objetivo de descarbonizar su red eléctrica y adaptarse a la jubilación de las anticuadas centrales de combustibles fósiles cercanas. En aquel momento, los vecinos expresaron su preocupación por dónde encontrarían energía limpia y constante si la primera central de su clase desaparecía, dada la limitada capacidad de conexión a nuevos proyectos eólicos y solares en la región. Ahora que el proyecto ha muerto, los escépticos del SMR dicen que los municipios deberían encontrar esas fuentes de energía más limpias y centrarse en tecnologías probadas. «Una de las historias que le han contado a la gente es que el SMR iba a ser mucho más barato que la energía nuclear a gran escala», dijo a WIRED el mes pasado David Schlissel, analista del Instituto de Economía Energética y Análisis Fiscal, una organización sin ánimo de lucro. «No es cierto». La portavoz de UAMPS, Jessica Stewart, dijo a WIRED que el grupo de servicios públicos ampliaría sus inversiones en un importante proyecto de parque eólico y buscaría otros contratos para proyectos geotérmicos, solares, de baterías y de gas natural.¿Fracaso exitoso?

En una llamada trimestral con inversores celebrada el miércoles, el consejero delegado de NuScale, John Hopkins, calificó el proyecto de «tremendo éxito» para la empresa, afirmando que los avances logrados con los reguladores federales para su diseño Voygr importaban más que el destino de una central individual. NuScale sigue estando algo por delante de sus competidores que trabajan en centrales nucleares más pequeñas. En 2022, fue la primera en recibir la aprobación de diseño de la Comisión Reguladora Nuclear de EE.UU., aunque un diseño actualizado previsto para sus proyectos iniciales aún requiere aprobación. En la convocatoria de inversores, otros ejecutivos de NuScale promocionaron los planes de la empresa para construir reactores en Rumanía y alimentar centros de datos en Pensilvania y Ohio construidos por Standard Power, una empresa de minería de criptomonedas. NuScale afirma que sigue planeando tener centrales operativas a mediados de la década de 2030. Los proyectos restantes de la empresa fueron cuestionados el mes pasado en un informe publicado por el vendedor en corto Iceberg Research. El grupo expresó dudas sobre la capacidad de Standard Power para gastar cientos de millones de dólares en la tecnología de NuScale, señalando los escasos detalles proporcionados sobre la empresa de criptomoneda y sus patrocinadores financieros. En la llamada del miércoles, NuScale defendió el proyecto, diciendo que esperaba proporcionar más detalles pronto. «Sabemos que los sitios que están desarrollando son sitios reales», dijo Robert Ramsey Hamady, director financiero de NuScale, que se incorporó a la empresa en agosto. En una declaración facilitada a través del portavoz de NuScale, Garrett Poorman, Standard Power negó las acusaciones del informe y afirmó que tenía acceso al capital adecuado. NuScale también publicó su propia respuesta. La empresa afirma que sigue centrada en hacer lo que se propuso: construir un nuevo tipo de reactor y demostrar que puede suministrar energía sin emisiones de carbono y las 24 horas del día a un coste más razonable que sus gigantescos antecesores, que siguen siendo un pilar de la red actual.Organización Latinoamericana de Energía: Normas para la certificacióno de «Hidrogeno Limpio»

Homenaje a Alberto Maroto: fundador de la química de reactores y centrales nucleares en la Argentina.

Comentario de AgendAR: Maroto y yo ya éramos un poco amigotes. Yo lo visitaba algunas veces en su casa de Belgrano: había salido muy averiado de huesos de la inmovilidad pandémica. Éste es uno de los 6 expertos que en 1985 me transformaron de antinuclear moderado a atómico convencido. Hijo de uno de los grandes galeristas de Baires y gran conocedor del ambiente, organizó el mejor museo de pintura argentina contemporánea, además, con 300 cuadros de grandes maestros donados voluntariamente a la CNEA (Comisión Nacional de Energía Atómica), su «alma mater». Están exhibidos en las paredes del edificio del acelerador de partículas TANDAR, en el Centro Atómico Constituyentes, sobre la General Paz, sin que el país se dé por enterado. Acceso a trasmano pero gratuito y obras muy significativas: olvidate del MALBA, éste es mejor. Antes, como químico de reactores, Maroto le hizo otro regalo equivalente a su alma mater, pero más medible. En los ’80 atajó un episodio de contaminación con resinas del circuito primario de enfriamiento de la central. Paradójicamente, eran las mismas resinas usadas para depurar el primario de productos de corrosión de metales. Un error de diseño de ese subsistema del proveedor canadiense, AECL, que habría dejado fuera de servicio durante años la que sigue siendo la mayor y mejor máquina individual de producción eléctrica del país desde 1984. Cuando en 1985 Maroto me habló por primera vez de su profesión y de su docencia formando nuevos químicos de reactores, en medio del reportaje usó sin pudor ni falsedad alguna la expresión de «pasar a la generación siguiente el fuego sagrado» y trató discretamente de disimular su emoción. Éramos dos perfectos desconocidos entonces, pero tuve por primera vez la sensación de que el Programa Nuclear era una Argentina desconocida, con funcionarios que eran más militantes «pro patria» que funcionarios. Una institución rarísima, con muchos defectos nuestros pero también con todas nuestras virtudes, sólo que muy, muy potenciadas. Yo era también un docente (de literatura) y recién empezaba en periodismo científico, como becario del hoy llamado Instituto Leloir. Desde ambas profesiones, podía entender perfectamente la tranquila vehemencia de aquel hombre por transmitir el fuego sagrado. Era inusitada esa emocionalidad por el país y por el bien público en un científico frente a un extraño, y para peor, periodista. Son cosas que por suerte me sucedieron varias veces en 37 años de carrera, pero ésa fue la primera y la más explícita. En las décadas que siguieron, Maroto y yo nos peleamos bastante por diferencias sobre política nuclear: era cortés y cortante, y muy vehemente. Debe haber sido un tremendo profesor, porque amaba la tarea, que en su caso iba de la química de reactores a la docencia, y de la docencia al arte. Maroto le dio de todo eso a manos llenas eso a nuestro país. Creo que su inmenso museo de pintura contemporánea en un edificio de investigación nuclear resume bien a la CNEA fundacional: lo mejor de lo mejor, en un país que no se da por enterado.Una triste noticia. Se nos fue Alberto Maroto, un gran colega de la @CNEA_Arg. Inspirador y creador del Depto de Química de Reactores, propulsor de ciencia, tecnología e innovación, y promotor de la nanotecnología. Además, un gran tipo. Lo vamos a extrañar. Abrazo a la familia pic.twitter.com/8m9Ot02txw

— Galo Soler Illia ⭐️⭐️⭐️ (@dr_kuato) November 13, 2023

Daniel E. Arias

El Wegovy, además de reducir peso, tiene algunos buenos efectos colaterales

EL WEGOVY REDUCE EL PESO Y EL SÍNDROME METABÓLICO, PERO NO HACE MAGIA, AUNQUE CUESTA COMO SI LA HICIERA

Los principales resultados positivos

- El semaglútido redujo en un 20% los acontecimientos graves en esta población de alto riesgo. Ëste es el primer fármaco dirigido a la obesidad que ha logrado este objetivo.

- El seguimiento de 40 meses es el más largo realizado hasta la fecha en un ensayo a gran escala de semaglútido contra placebo, lo que confirma en cierta medida la seguridad de esta duración del tratamiento.

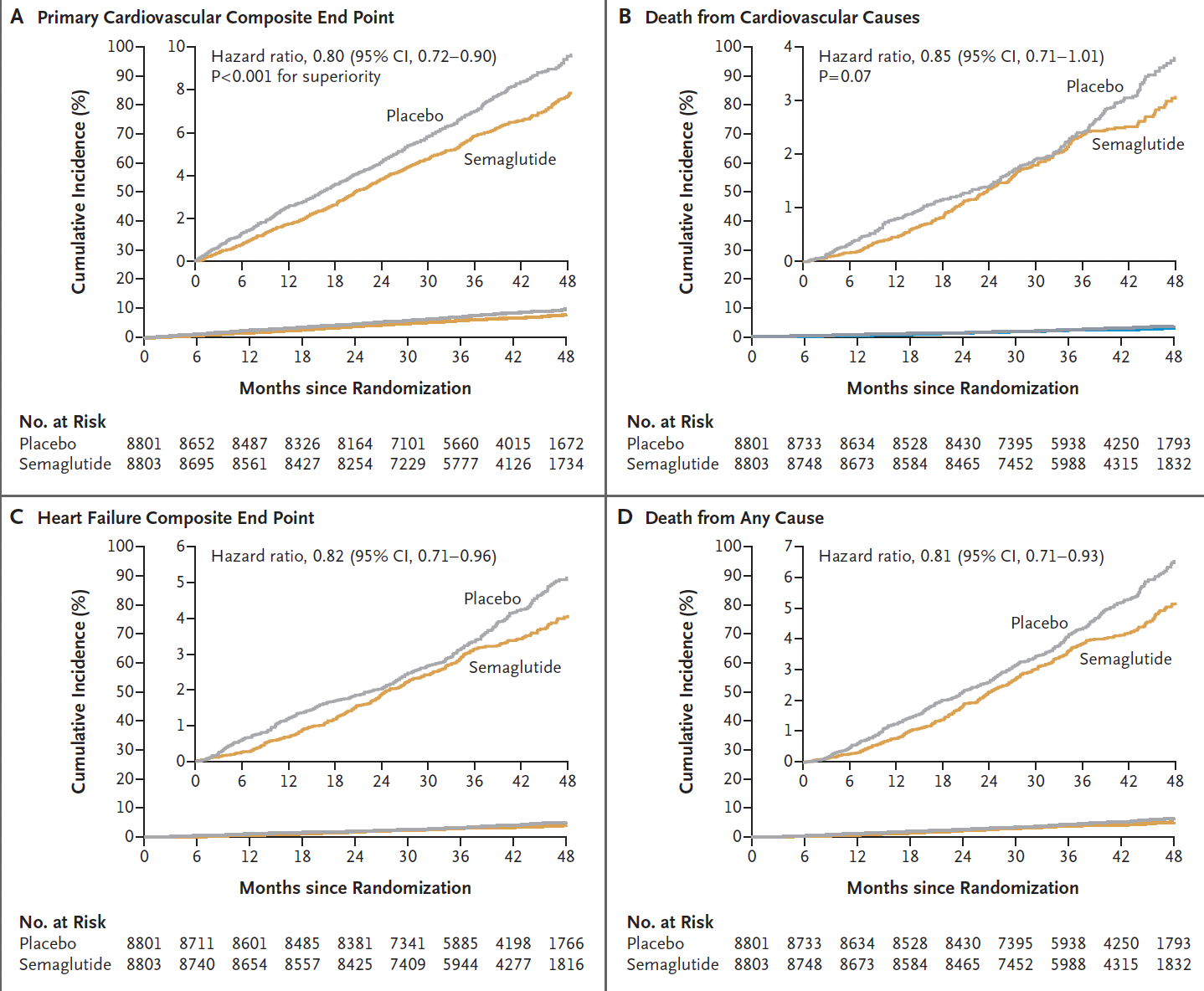

- Hubo una reducción bastante consistente de más o menos el 20% en los diferentes criterios de valoración, aunque el tiempo observado para la divergencia de las curvas de muerte cardiovascular o muerte por cualquier otra causa (gráficos a continuación) se retrasó más de 3 años, en comparación con la separación temprana de las curvas para los criterios de valoración no mortales (principalmente reducción del infarto de miocardio).

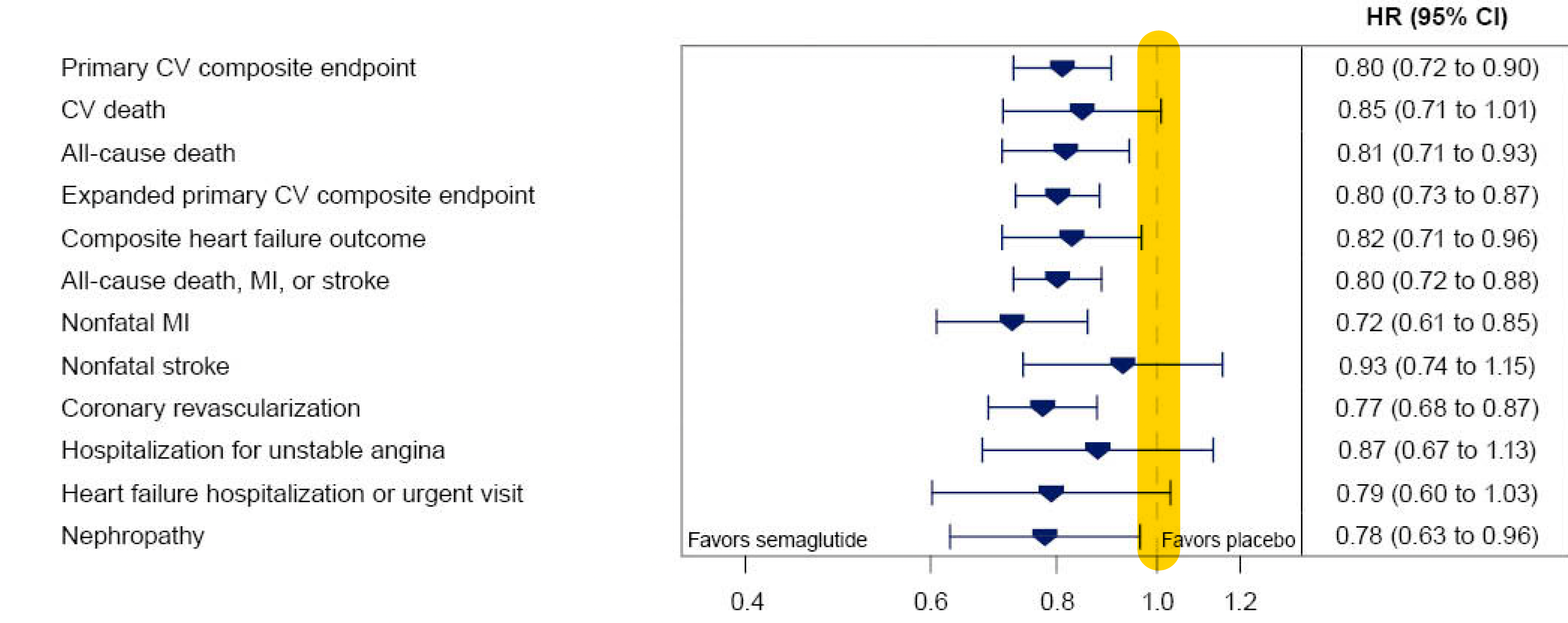

Éste es el análisis del tiempo transcurrido hasta el acontecimiento, que muestra de nuevo la reducción del infarto de miocardio no mortal, mientras que el ictus no mortal no se redujo significativamente (una reducción relativa del 7%). La línea vertical amarilla es la línea de identidad (cociente de riesgos de 1,0); si los intervalos de confianza del 95% la cruzan, ese resultado específico no es estadísticamente significativo.

Éste es el análisis del tiempo transcurrido hasta el acontecimiento, que muestra de nuevo la reducción del infarto de miocardio no mortal, mientras que el ictus no mortal no se redujo significativamente (una reducción relativa del 7%). La línea vertical amarilla es la línea de identidad (cociente de riesgos de 1,0); si los intervalos de confianza del 95% la cruzan, ese resultado específico no es estadísticamente significativo.

- Como cabía esperar, la reducción de la progresión a diabetes fue sorprendente: sólo el 3,5% progresó a HbA1c > 6,5% en el grupo de semaglutida frente al 12% en el grupo placebo, lo que supone una reducción del 73%. Junto a esto, se produjo una reducción bastante pronunciada del marcador inflamatorio proteína C reactiva, que bajó un 39% frente a un 3%, en el caso del semaglútido contra placebo, respectivamente.

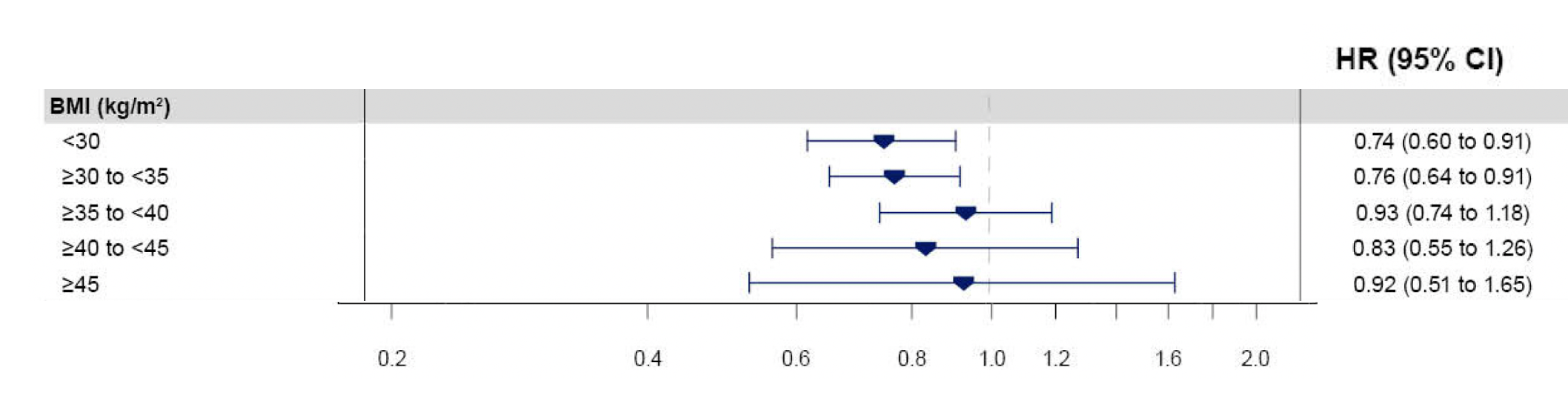

- Los resultados fueron independientes de la categoría de sobrepeso/obesidad al inicio del estudio, como se observa en este análisis de subgrupos para el objetivo primario. De hecho, los subgrupos con menos de 30 y más de 30-35 de índice de masa corporal IMC demostraron la mayor reducción relativa.

Resultados no tan buenos

- La reducción absoluta del criterio de valoración primario es de sólo 1,5 por cada 100 personas tratadas, y las personas del ensayo representan una cohorte de muy alto riesgo. Además, tuvieron que ser tratados durante más de 3 años para obtener ese pequeño beneficio absoluto. Téngase en cuenta que el precio de Wegovy en Estados Unidos es de 1.349 dólares al mes.

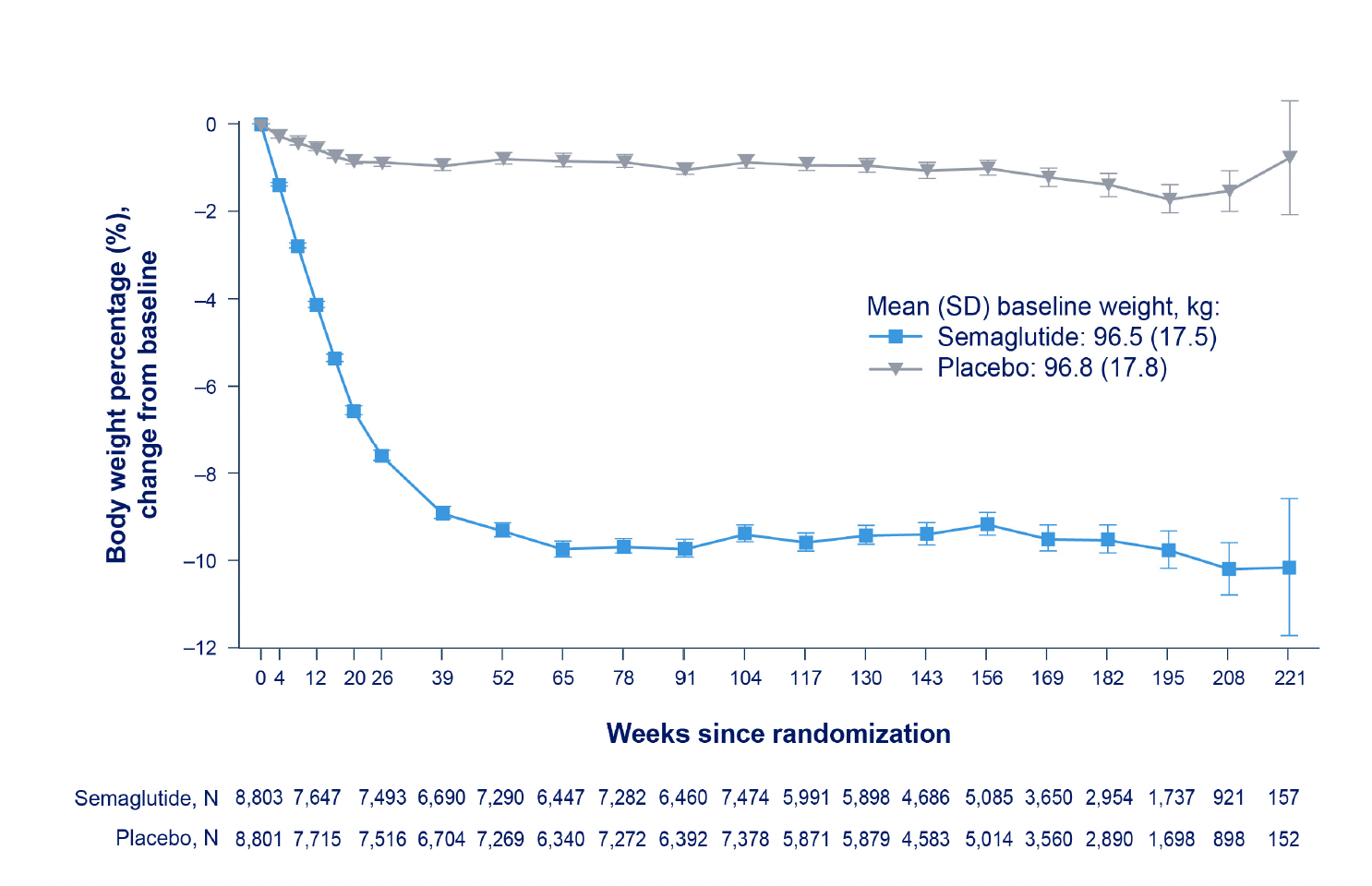

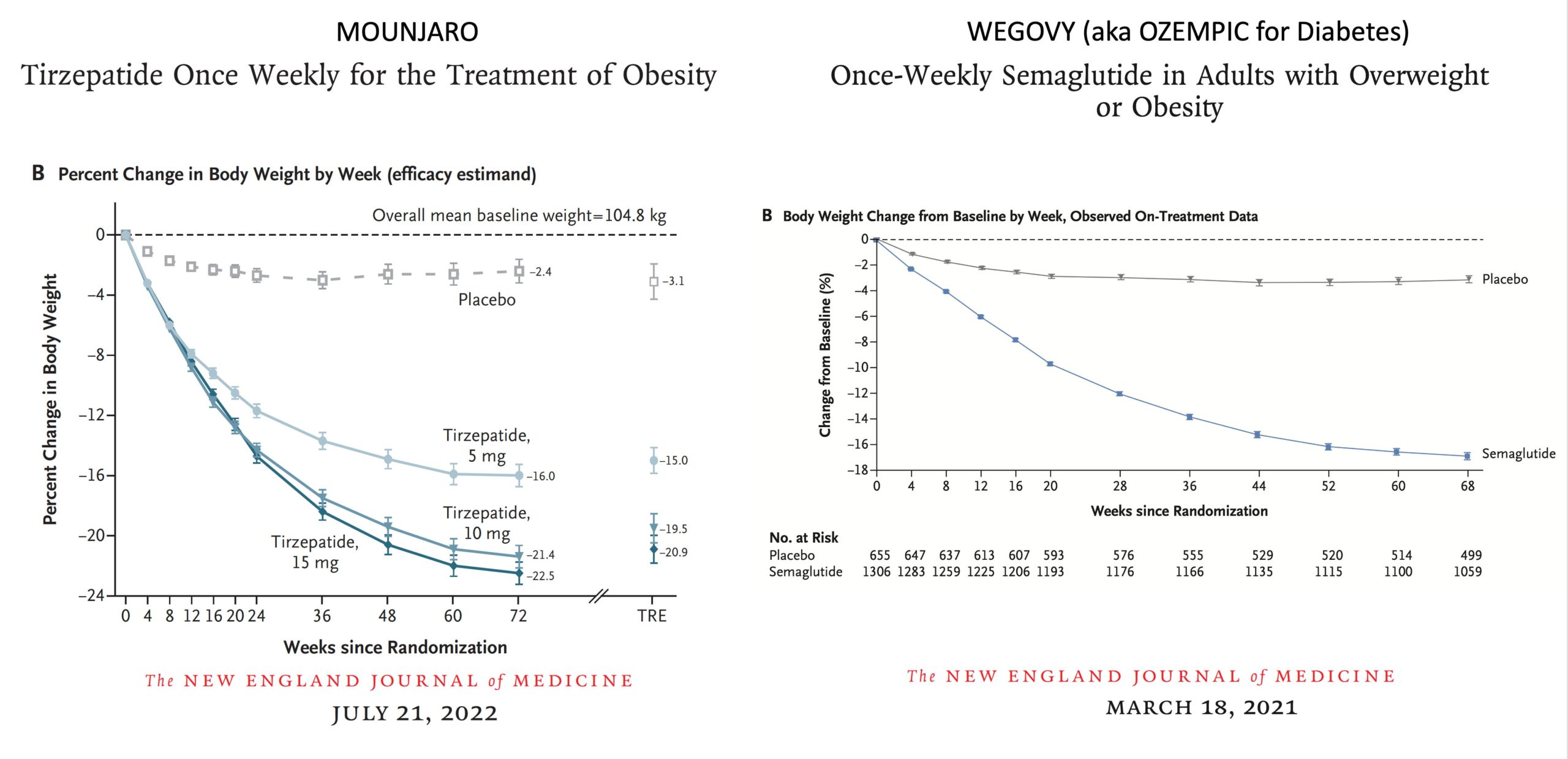

- La pérdida de peso corporal conseguida fue sólo del 8,5%. Como comenté el pasado diciembre, esto es considerablemente menos de lo que se observó en los ensayos aleatorizados anteriores de Wegovy y Mounjaro, más pequeños y con menos tiempo de seguimiento (<1,5 años).

- Queda por ver si una pérdida de peso mayor reduciría aún más los episodios cardiovasculares, y en qué medida la pérdida de peso en sí afectaba a la mejora de los resultados o se debía en parte a otros efectos del fármaco, como la reducción de la inflamación.

Ensayos aleatorizados previos de GLP-1 para la reducción de la pérdida de peso

Ensayos aleatorizados previos de GLP-1 para la reducción de la pérdida de peso

- No existe una estrategia de salida. Más allá de la pérdida de peso, sabemos que las personas que toman estos fármacos pierden masa muscular (no medida en el ensayo) y densidad ósea, y las empresas que comercializan estos fármacos no han hecho nada para evaluar las estrategias de retirada y suspensión de los fármacos para evitar estos efectos adversos, sin olvidar otros que pueden aparecer tras una exposición prolongada (varios años).

Resumen

Este ensayo aleatorizado del fármaco GLP-1, bien realizado, es importante para documentar la reducción de los eventos cardiovasculares en una cohorte de alto riesgo. Pero la reducción absoluta (1,5 por cada 100 tratados durante >3 años) es bastante baja, sobre todo teniendo en cuenta el alto riesgo de la población y el elevado coste del fármaco. Pagar de bolsillo propio el precio completo de 1.349 dólares al mes durante 36 meses equivale a más de 48.500 dólares. Es probable que las aseguradoras, y Medicare, revisen su cobertura basándose en el ensayo para cubrir el fármaco para pacientes de alto riesgo que cumplan los criterios de entrada del ensayo, pero eso representará una carga económica muy grande para cubrir el coste del fármaco. La aprobación por la FDA de Zepbound (tirzepatide, igual que Mounjaro pero con otro nombre) esta semana, con un coste de 1.060 dólares, parece un poco mejor. Es probable que el acceso a estos fármacos agrave las desigualdades, lo que se suma a la falta de diversidad de las personas evaluadas en el ensayo. Se necesita mucho más trabajo para resolver la cuestión del beneficio del GLP-1 para las personas obesas pero sin infartos previos o con alto riesgo de eventos cardiovasculares; aún no sabemos nada al respecto. Es posible que los fármacos GLP-1 más potentes y los agonistas de triple receptor consigan un mayor grado de pérdida de peso y amplíen el beneficio a las personas de menor riesgo en el futuro. Todo eso está por ver, y un beneficio absoluto de 1,5 por cada 100 personas tratadas no es nada del otro mundo. Para mí, la mayor preocupación es que estas empresas parecen estar promoviendo una terapia vitalicia, como es evidente por su nula voluntad de sacar a la gente de los medicamentos sin volver a tomarlos, tanto por el aumento de peso consiguiente como por el riesgo de resultados adversos. Esto es claramente inaceptable y se necesita una mayor presión para que todas las empresas que fabrican este tipo de fármacos prueben y validen estrategias de salida duraderas y seguras..ERIC TOPOL

Dia Mundial de la Diabetes. La situacion de la Argentina y otros paises de America

La falta de tecnología en América Latina

En Argentina, la Ley Nacional de Diabetes garantiza el acceso a servicios esenciales para mejorar el control glucémico y reducir complicaciones, incluyendo insulinas análogas o bombas de insulina. Sin embargo, la escasez de suministros médicos y la inestabilidad económica afectan el acceso a estas tecnologías. «Los principales desafíos son la accesibilidad a las nuevas tecnologías y el costo que conlleva la no cobertura o cobertura parcial de las mismas. Esto genera un gran desgaste en el sistema de salud, en los médicos y, sobre todo, en los pacientes”, explicó Rodrigo Carnero, miembro de la Sociedad Argentina de Diabetes Capitulo Córdoba. En Chile, la Ley Ricarte Soto proporciona protección financiera a pacientes con condiciones específicas de salud, como enfermedades oncológicas, inmunológicas, raras o poco frecuentes, para el diagnóstico y tratamiento de alto costo. Esta ley contempla el acceso a terapias innovadoras, incluyendo insulinas análogas, sistemas de administración automatizada de insulina y dispositivos de monitoreo continuo de glucosa, como las bombas de insulina, que permiten un control y tratamiento más preciso y efectivo al suministrar la insulina de forma dinámica, ajustándose a las necesidades del organismo de la persona que padece esta enfermedad. Al mismo tiempo, en Colombia, el acceso a tratamientos innovadores como la insulina análoga y los sistemas de administración automatizada de insulina está contemplado tanto en el régimen contributivo como en el régimen subsidiado de salud. Esto facilita el control de la enfermedad y evita complicaciones a corto y mediano plazo que podrían representar mayores costos para pacientes, familiares y entidades de salud. A pesar de estos avances, todavía existen barreras que afectan a los pacientes para lograr un control adecuado de esta patología. “Aunque existen facilidades para acceder a tratamientos, las barreras que dificultan el acceso de los pacientes a este tipo de tecnología generalmente se deben al desconocimiento de algunos especialistas sobre estas tecnologías, la desinformación por parte de las personas y sus familiares, o retrasos administrativos de las Entidades Promotoras de Salud”, explicó Alexandra Gómez, directora de la Fundación ASUBIM. Un ejemplo de esto es Perú, en donde los pacientes con diabetes tipo 1 continúan siendo tratados con insulina humana, un enfoque en desuso a nivel global y que solo persiste en países con recursos muy limitados. Este tipo de tratamientos se suele asociar con complicaciones como la hipoglucemia y una gran variabilidad glucémica que no logra un control efectivo de la condición. Esta falta de inversión en tecnología en Perú no solo deteriora la calidad de vida de los pacientes, sino que representa una alta carga para el sistema de salud. Por otra parte, en el caso de México, las personas con diabetes tipo 1 deben acudir a un hospital de tercer nivel del sector salud y/o ser beneficiario de alguna asociación de pacientes para tener acceso a tratamientos con insulina, pero no pueden acceder a tecnologías como los sistemas de administración automatizada de insulina (también llamados bombas) y de monitoreo continuo de glucosa. Es por esto que los expertos señalan la importancia de seguir las buenas prácticas de países como Argentina, Colombia y Chile, e impulsar la implementación de políticas de salud pública en cada país. A su vez, destacan la necesidad de alinear la legislación con la realidad operativa, asegurando que lo establecido por la ley se refleje efectivamente en la práctica médica.La CONAE realizo una campaña en Península Valdés para la Misión SAOCOM

La Armada Argentina y la de Chile preparan un Patrullaje Antártico Combinado

En una ceremonia marcada por la solemnidad y la preparación meticulosa, el Aviso ARA “Estrecho de San Carlos” zarpó desde la dársena de la Base Naval Puerto Belgrano con destino a Ushuaia. La travesía, que se enmarca en la XXVI Patrulla Antártica Naval Combinada (PANC), representa una destacada colaboración entre la Armada Argentina y la Armada de Chile, consolidando su compromiso con la preservación del medioambiente y la seguridad marítima en la región.

Presidiendo la ceremonia de zarpada, el Vicealmirante Jorge Juan Siekan, Comandante de Adiestramiento y Alistamiento de la Armada, lideró el evento junto al Contraalmirante Carlos María Allievi, Comandante de la Flota de Mar, y el Capitán de Navío Pedro Mariano Brandolín, Comandante Naval Anfibio y Logístico.

Tras concluir las labores de carenado y reparaciones en el dique del Arsenal Naval Puerto Belgrano, el Aviso ARA “Estrecho de San Carlos” se embarca en su misión hacia el Área Naval Austral, donde desempeñará un papel crucial en la PANC. El Capitán de Corbeta Arnaldo Gabriel Ozuna, Comandante de la unidad, informó al Comandante de la Flota de Mar el estado de “listo a zarpar“, recibiendo la autorización para iniciar el despliegue hacia la Base Naval de Ushuaia.

Dirigiéndose a la tripulación, el Vicealmirante Siekan expresó sus felicitaciones por el arduo trabajo realizado durante el periodo de alistamiento, instándolos a enaltecer la imagen y el honor de la Flota de Mar, considerada el corazón de la Armada. Sus palabras concluyeron con deseos de éxitos y buenos vientos para la travesía.

La Importancia de la Patrulla Antártica Naval Combinada (PANC)

La PANC, concebida a partir de los acuerdos del Tratado de Paz y Amistad de 1984, tiene como objetivo primordial la salvaguarda de la vida humana en el mar y la preservación del medioambiente en la región antártica. Operativamente, depende de los comandos del Área Naval Austral de la Armada Argentina y de la Tercera Zona Naval de la Armada de Chile, manteniéndose de manera ininterrumpida desde 1998.

Esta colaboración binacional cobra especial relevancia durante la temporada estival, cuando el tráfico marítimo en la Antártida se intensifica debido a actividades científicas, turísticas y comerciales. La PANC, reconocida por la Organización Marítima Internacional (OMI), despliega sus esfuerzos para patrullar y garantizar la seguridad náutica en esta área crítica.

La función principal de la PANC abarca servicios de búsqueda, rescate, salvamento marítimo, control y combate de la contaminación. Su misión es proporcionar seguridad a la navegación, proteger la vida humana en el mar y contribuir a mantener las aguas libres de contaminación al sur del paralelo 60º S, conforme a lo establecido en el Tratado Antártico. Este compromiso conjunto refleja la responsabilidad compartida de ambas Armadas en la preservación de un entorno marino único y fundamental.

Eduardo Gigante: «INVAP, radares, Fuerzas Armadas Argentinas y soberanía nacional»

Cuando el ex secretario de estado de Trump (EEUU), Rex Tillerson, visito el país por primera vez. Tillerson, puso en su agenda durante la visita, como PRIMER escala, la visita a INVAP en Bariloche, es decir llego directamente a las instalaciones de INVAP aún antes que visitar Buenos Aires, ¿Por qué? Bueno, según me comentaron, estaba muy muy interesado en dos temas, centrales nucleares y RADARES……. Y aquí comienzo la historia, el primer radar que obtuvo el país, fue una compra a los británicos (desarrolladores de esta tecnología), en el año 48 durante el gobierno de J.D.Peron, y comenzaron a ser operados por la FAASobre INVAP, Radares, Fuerzas Armadas Argentinas y soberanía nacional y tecnológica. Este hilo surgió debido a que tuve la oportunidad de escuchar a un Brigadier contando sobre la radarización del país, y me vino el recuerdo de hace algunos años atrás+ pic.twitter.com/EmZbz4PHrD

— Eduardo Gigante 🔋⛓️🥽🦺🏭 (@eddiegigante) November 8, 2023

En 1953, obviamente era una tecnología totalmente nueva desarrollada en la década del 30, así que, en esa época, y si bien desarrollamos capacidades en fabricación de aviones con éxito, era imposible que avancemos en esa tecnología

Más allá de esto Argentina fue pionera en la utilización de este tipo de tecnología, lo que permitió que se ganen algunas capacidades en temas de conocimiento de la misma, pero muy muy lejos de un desarrollo

En el año 1996, C.S.Menem firma el decreto 145/96 para la compra llave en mano de un sistema que integrara el tráfico aéreo con el control aéreo (esto utiliza distinto tipos de radares, que más adelante explicare claramente). La cuestión es que no llego a ejecutarse, debido a irregularidades en la licitación, que provoco la caída de la misma. Argentina ya tenía equipos en algunos casos obsoletos que eran necesario reemplazar a la brevedad, pero llego el 2001 y todo el caos.

Además de esto, el fabricante de los radares que argentina operaba, comunicaba que descontinuaba la venta de repuestos, profundizando aún más el problema, siendo además que en el medio hubo el ataque terrorista a las torres gemelas, que endureció la venta de esta tecnología, en síntesis, al no poseer la tecnología, se complicaba mucho la continuidad del control del espacio aéreo argentino.

En 2003, durante la presidencia de Duhalde, se firmó el primer acuerdo entre el INVAP y la FAA para la fabricación de un radar en Argentina. Este preveía el diseño, desarrollo, construcción y puesta en funcionamiento de un prototipo de radar secundario. El Radar Secundario Monopulso Argentino, y aquí hago un paréntesis, existen varios tipos de radares, pero principalmente existen de dos tipos, los radares primarios y los radares secundarios.

¿Qué los diferencia a uno u otro?, bueno que el radar primario, utilizados con fines de defensa y control del espacio aéreo, no requieren “colaboración” del objeto detectado para obtener información acerca de su distancia al radar, respecto a éste y/o altura.

En cambio, los radares secundarios utilizados también en control de tránsito aéreo y defensa, constan de un emisor terrestre que envía pulsos codificados que son respondidos por un artefacto llamado transponder, ubicado a bordo del avión, que da información sobre el mismo.

Volvemos a la historia, en 2004, el entonces Presidente Kirchner firma el decreto 1407/04, que creaba el Sistema Nacional de Vigilancia y Control del Aeroespacio (SINVICA). Este organismo integraba la información de radares en todo el territorio argentino

-“El impulso dado por los gobiernos kirchneristas (2003-2015) al diseño y fabricación de radares basado en el mencionado Decreto 1407/04 se materializó en forma paulatina: en noviembre de 2006 el Ministerio de Defensa aprobó el contrato firmado entre la FAA e INVAP para la provisión de un prototipo del RSMA y la posterior fabricación e instalación de una serie de diez de estos radares secundarios”- Fuente: Producción Nacional de Radares: Expresión de una soberanía tecnológica posible Universidad de la Plata

Luego en 2008, se encargó a Invap la construcción de un Radar Primario, a (Radar Primario Argentino 3D de Largo Alcance o RPA3D-LA).

Invap, diseño y construyo varios radares primarios y secundarios e instruyo a sus operadores con desarrollos argentinos desde 0! y UTILIZANDO SOLO EL 15% de partes importadas, todo esto permitió pasar de tener nuestro espacio aéreo.

Soberanía Tecnológica 100%, cuantos países pueden fabricar radares? China, Rusia, Gran Britania, EEUU, Francia, España, Holanda, Suecia, Alemania…..y creo que no me olvido de ninguno.

Además de esto, INVAP ya exporto el primer Radar, a Nigeria, posesionándose en el mercado de manera sólida. ¡Como siempre digo, la ciencia y la industria salvara a la nación, y el caso de INVAP es el comienzo de ello, mostrando lo que somos capaces de hacer!

Es importante, y cierro el hilo, tener en cuenta que candidato a presidente impulsa estos desarrollos y cual no los impulsara jamás. Y otra cosa, la radarización de nuestro país, termino saliendo 5,5 veces menos que un llave en mano extranjero.

Comentario de AgendAR:

No nos consta que Rex Tillerson, o T-Rex según sus fans petroleros, visitara INVAP en su «toco y despego» por Bariloche para informarse sobre los radares argentinos. Más bien parece que el entonces Secretario de Estado de Trump estaba acrecentando su fortuna comprándose algunas tierritas en los Andes Patagónicos, aunque usando para ello un avión oficial de la Fuerza Aérea de los EEUU.

Nadie se asuste: los petroleros saben exactamente cómo están jodiendo el clima planetario. Muchos millonarios gringos hacen lo mismo que don T-Rex, sabiendo que en la Patagonia Andina habrá agua pura de deshielo y temperaturas soportables durante varias décadas más.

Eso con el plus de que pueden cerrar caminos, apropiarse de orillas pertenecientes al estado federal, y hacer lo que se les cante en sus tierras, sin que las leyes de este país los salpiquen siquiera. Es lo que pasa con no sé qué inglés que se choreó un lago entero en Río Negro, y con un fabricante italiano de ropa cheta que se las da de multicultural, pero maneja Santa Cruz y Chubut como si fueran dos de sus estancias, la Gendarmería como su guardia privada, y vive expulsando mapuches.

Otrosí digo: nadie tiene la más mínima intención de cerrar el formidable RA-3, aunque haya entrado en servicio en 1967. Desde entonces, ese reactor fue repotenciado dos veces, de 3 a 5 y de 5 a 10 megavatios térmicos, y en cada una de esos cambios de potencia se reforzaron todos sus circuitos de refrigeración y sus sistemas de irradiación y control. Eso le permitió ser la fuente de radioisótopos médicos más productiva y confiable del Hemisferio Sur, salvo por la competencia que le hizo desde 1987 el RP-10 de Perú y desde 2006 el OPAL de Australia, dos reactores de 10 y de 20 MW respectivamente, ambos diseñados y construidos por la Argentina.

Ahora vamos a tener un monstruito de 30 MW, capaz de dominar (con el márketing adecuado) el 20% del mercado mundial de radioisótopos médicos, además de producir todos los años silicio irradiado para la industria fotovoltaica de alto rendimiento. En 2022 se vendieron U$ 679,8 millones de dólares de radioisótopos. Y la cifra trepa en rampa desde hace décadas, sin que se vea un techo.

Es probable que exportando esos radiofármacos el RA-10 pague su propio costo de diseño y construcción en 6 o 7 meses, y que dure en servicio al menos 50 años. Mucho más que eso, si sale tan robusto como su antecesor, el RA-3. Aunque la opción de vender al menos U$ 40 millones más de silicio irradiado por año (para empezar) lo termina de volver el mejor negocio de la historia nuclear argentina, hasta el momento.

Por esa misma causa, salvo que la ARN (Autoridad Regulatoria Nuclear) lo considere inseguro, nadie en sus cabales piensa cerrar el RA-3, que viene siendo la gallina de los huevos de oro actual. Y sigue muy ponedora.

Daniel E. Arias

En 1953, obviamente era una tecnología totalmente nueva desarrollada en la década del 30, así que, en esa época, y si bien desarrollamos capacidades en fabricación de aviones con éxito, era imposible que avancemos en esa tecnología

Más allá de esto Argentina fue pionera en la utilización de este tipo de tecnología, lo que permitió que se ganen algunas capacidades en temas de conocimiento de la misma, pero muy muy lejos de un desarrollo

En el año 1996, C.S.Menem firma el decreto 145/96 para la compra llave en mano de un sistema que integrara el tráfico aéreo con el control aéreo (esto utiliza distinto tipos de radares, que más adelante explicare claramente). La cuestión es que no llego a ejecutarse, debido a irregularidades en la licitación, que provoco la caída de la misma. Argentina ya tenía equipos en algunos casos obsoletos que eran necesario reemplazar a la brevedad, pero llego el 2001 y todo el caos.

Además de esto, el fabricante de los radares que argentina operaba, comunicaba que descontinuaba la venta de repuestos, profundizando aún más el problema, siendo además que en el medio hubo el ataque terrorista a las torres gemelas, que endureció la venta de esta tecnología, en síntesis, al no poseer la tecnología, se complicaba mucho la continuidad del control del espacio aéreo argentino.

En 2003, durante la presidencia de Duhalde, se firmó el primer acuerdo entre el INVAP y la FAA para la fabricación de un radar en Argentina. Este preveía el diseño, desarrollo, construcción y puesta en funcionamiento de un prototipo de radar secundario. El Radar Secundario Monopulso Argentino, y aquí hago un paréntesis, existen varios tipos de radares, pero principalmente existen de dos tipos, los radares primarios y los radares secundarios.

¿Qué los diferencia a uno u otro?, bueno que el radar primario, utilizados con fines de defensa y control del espacio aéreo, no requieren “colaboración” del objeto detectado para obtener información acerca de su distancia al radar, respecto a éste y/o altura.

En cambio, los radares secundarios utilizados también en control de tránsito aéreo y defensa, constan de un emisor terrestre que envía pulsos codificados que son respondidos por un artefacto llamado transponder, ubicado a bordo del avión, que da información sobre el mismo.

Volvemos a la historia, en 2004, el entonces Presidente Kirchner firma el decreto 1407/04, que creaba el Sistema Nacional de Vigilancia y Control del Aeroespacio (SINVICA). Este organismo integraba la información de radares en todo el territorio argentino

-“El impulso dado por los gobiernos kirchneristas (2003-2015) al diseño y fabricación de radares basado en el mencionado Decreto 1407/04 se materializó en forma paulatina: en noviembre de 2006 el Ministerio de Defensa aprobó el contrato firmado entre la FAA e INVAP para la provisión de un prototipo del RSMA y la posterior fabricación e instalación de una serie de diez de estos radares secundarios”- Fuente: Producción Nacional de Radares: Expresión de una soberanía tecnológica posible Universidad de la Plata

Luego en 2008, se encargó a Invap la construcción de un Radar Primario, a (Radar Primario Argentino 3D de Largo Alcance o RPA3D-LA).

Invap, diseño y construyo varios radares primarios y secundarios e instruyo a sus operadores con desarrollos argentinos desde 0! y UTILIZANDO SOLO EL 15% de partes importadas, todo esto permitió pasar de tener nuestro espacio aéreo.

Soberanía Tecnológica 100%, cuantos países pueden fabricar radares? China, Rusia, Gran Britania, EEUU, Francia, España, Holanda, Suecia, Alemania…..y creo que no me olvido de ninguno.

Además de esto, INVAP ya exporto el primer Radar, a Nigeria, posesionándose en el mercado de manera sólida. ¡Como siempre digo, la ciencia y la industria salvara a la nación, y el caso de INVAP es el comienzo de ello, mostrando lo que somos capaces de hacer!

Es importante, y cierro el hilo, tener en cuenta que candidato a presidente impulsa estos desarrollos y cual no los impulsara jamás. Y otra cosa, la radarización de nuestro país, termino saliendo 5,5 veces menos que un llave en mano extranjero.

Comentario de AgendAR:

No nos consta que Rex Tillerson, o T-Rex según sus fans petroleros, visitara INVAP en su «toco y despego» por Bariloche para informarse sobre los radares argentinos. Más bien parece que el entonces Secretario de Estado de Trump estaba acrecentando su fortuna comprándose algunas tierritas en los Andes Patagónicos, aunque usando para ello un avión oficial de la Fuerza Aérea de los EEUU.

Nadie se asuste: los petroleros saben exactamente cómo están jodiendo el clima planetario. Muchos millonarios gringos hacen lo mismo que don T-Rex, sabiendo que en la Patagonia Andina habrá agua pura de deshielo y temperaturas soportables durante varias décadas más.

Eso con el plus de que pueden cerrar caminos, apropiarse de orillas pertenecientes al estado federal, y hacer lo que se les cante en sus tierras, sin que las leyes de este país los salpiquen siquiera. Es lo que pasa con no sé qué inglés que se choreó un lago entero en Río Negro, y con un fabricante italiano de ropa cheta que se las da de multicultural, pero maneja Santa Cruz y Chubut como si fueran dos de sus estancias, la Gendarmería como su guardia privada, y vive expulsando mapuches.

Otrosí digo: nadie tiene la más mínima intención de cerrar el formidable RA-3, aunque haya entrado en servicio en 1967. Desde entonces, ese reactor fue repotenciado dos veces, de 3 a 5 y de 5 a 10 megavatios térmicos, y en cada una de esos cambios de potencia se reforzaron todos sus circuitos de refrigeración y sus sistemas de irradiación y control. Eso le permitió ser la fuente de radioisótopos médicos más productiva y confiable del Hemisferio Sur, salvo por la competencia que le hizo desde 1987 el RP-10 de Perú y desde 2006 el OPAL de Australia, dos reactores de 10 y de 20 MW respectivamente, ambos diseñados y construidos por la Argentina.

Ahora vamos a tener un monstruito de 30 MW, capaz de dominar (con el márketing adecuado) el 20% del mercado mundial de radioisótopos médicos, además de producir todos los años silicio irradiado para la industria fotovoltaica de alto rendimiento. En 2022 se vendieron U$ 679,8 millones de dólares de radioisótopos. Y la cifra trepa en rampa desde hace décadas, sin que se vea un techo.

Es probable que exportando esos radiofármacos el RA-10 pague su propio costo de diseño y construcción en 6 o 7 meses, y que dure en servicio al menos 50 años. Mucho más que eso, si sale tan robusto como su antecesor, el RA-3. Aunque la opción de vender al menos U$ 40 millones más de silicio irradiado por año (para empezar) lo termina de volver el mejor negocio de la historia nuclear argentina, hasta el momento.

Por esa misma causa, salvo que la ARN (Autoridad Regulatoria Nuclear) lo considere inseguro, nadie en sus cabales piensa cerrar el RA-3, que viene siendo la gallina de los huevos de oro actual. Y sigue muy ponedora.

Daniel E. Arias

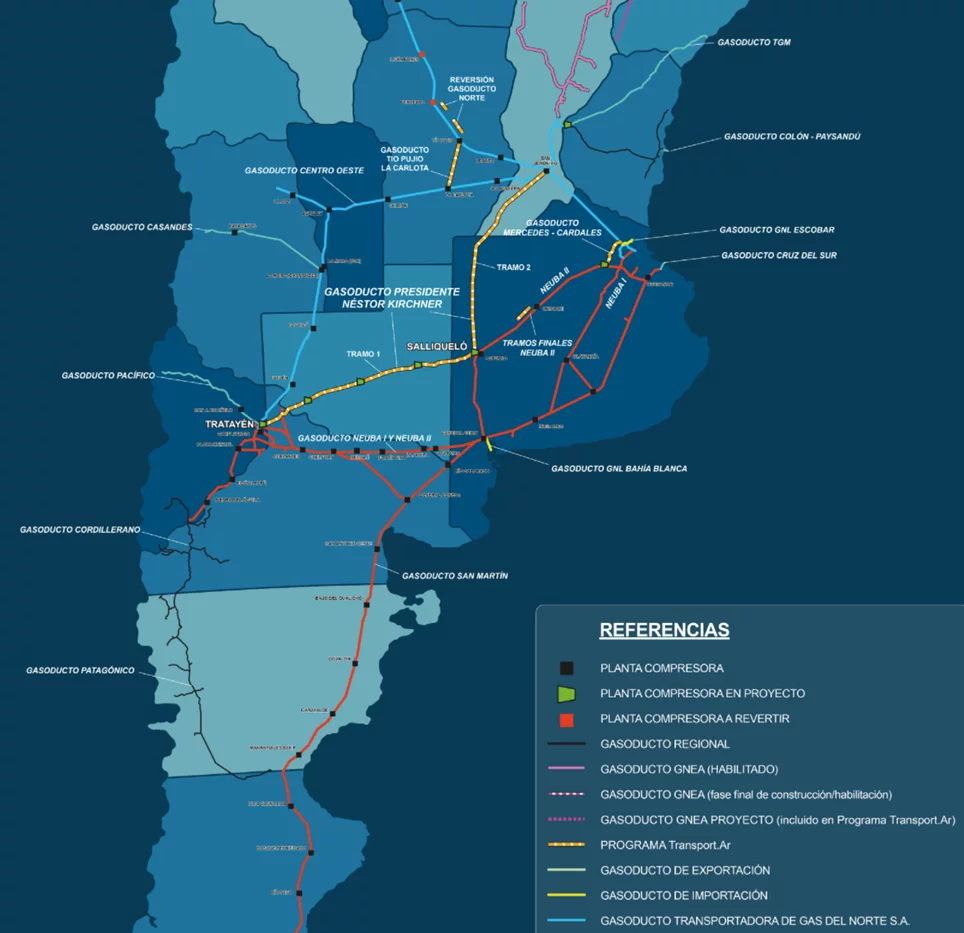

El gasoducto Nestor Kircher: Cuanto ahorrara en importaciones Argentina

Un análisis del efecto que tendrán las expansiones de los gasoductos sobre los costos de generación y subsidios eléctricos.

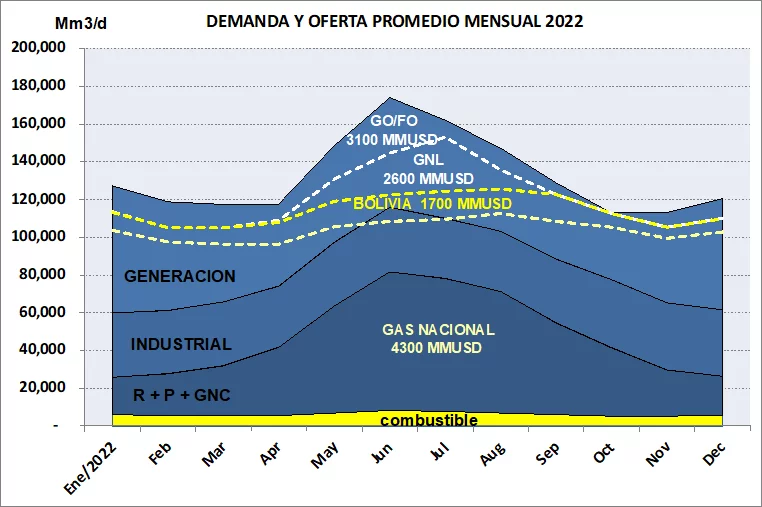

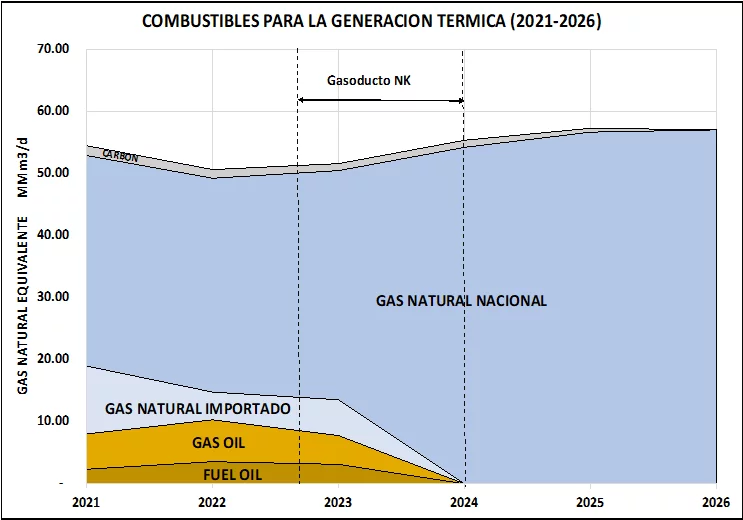

La figura 1 muestra la demanda y oferta promedio mensual de gas natural y sus combustibles sustitutos del año 2022 para todo el sistema argentino de gas natural (no sólo para generación eléctrica). Tomando como referencia la situación de ese año, el sistema argentino de gas natural funcionó con una inyección promedio anual de unos 101 millones de metros cúbicos (m3) de gas nacional, unos 10,5 MMm3/d de gas de Bolivia y, para cubrir los picos invernales entre mayo y septiembre, unos 30 MMm3/d de GNL. Adicionalmente, existió una demanda insatisfecha de gas natural para la generación térmica que fue cubierta con 11,7 MMm3/d de combustibles líquidos (fundamentalmente gasoil), tal como se muestra en la figura.

Evolución esperada de los costos de generación de electricidad 2023-2026

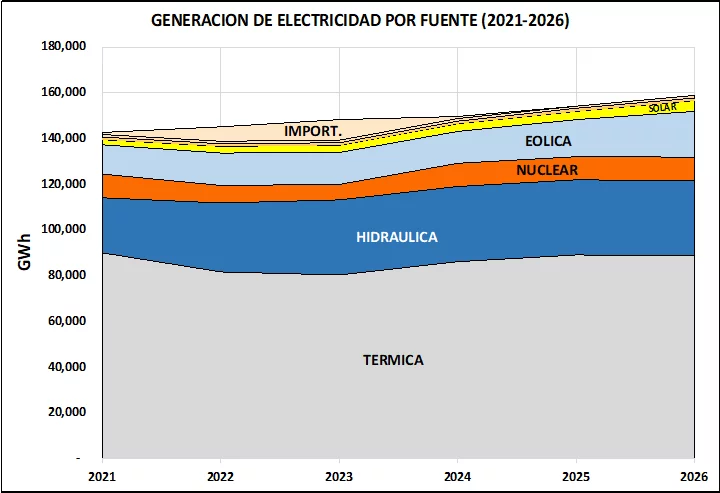

Como vimos en la sección precedente, el cambio fundamental de corto plazo en el sistema energético argentino es la puesta en marcha del GPNK, que permite la incorporación de nuevos caudales de gas natural desde el yacimiento de Vaca Muerta. En la figura 3 se muestra la generación de electricidad por fuente (2021-2026). El aumento de la generación térmica por la mayor disponibilidad de gas natural y la recuperación esperada de la generación de energía nuclear permitirían reducir a un mínimo las elevadas importaciones de electricidad de los años 2022 y 2023. A partir del año 2025, se requeriría la incorporación de aproximadamente 2.000 GWh y 4.000 GWh de generación renovable en los años 2025 y 2026, respectivamente, para cubrir el aumento esperado de la demanda de electricidad sin aumentar la emisión de Gases de Efecto Invernadero (GEI) por MWh del sistema eléctrico.

Esquema posible de quita de subsidios a la generación eléctrica

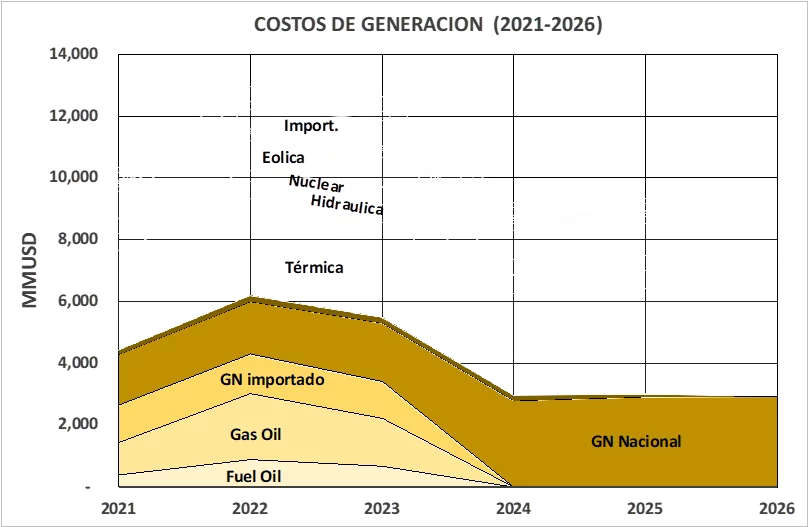

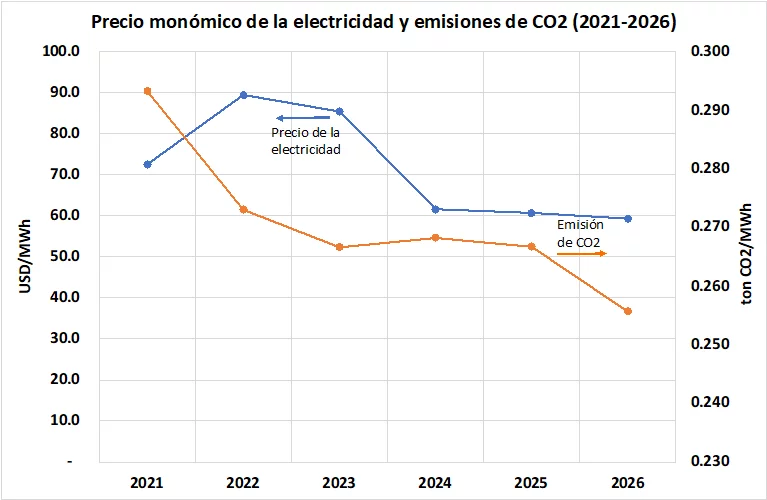

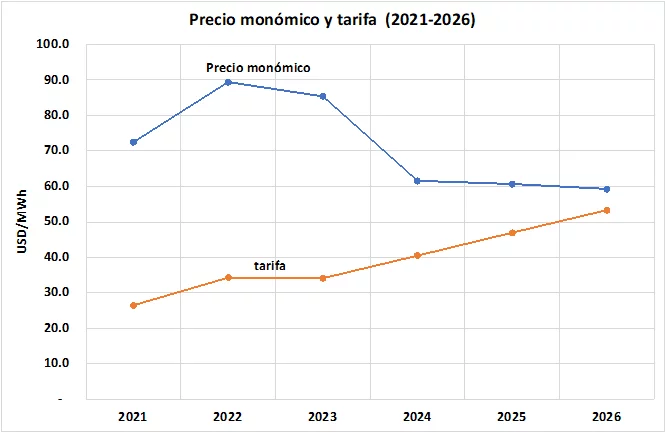

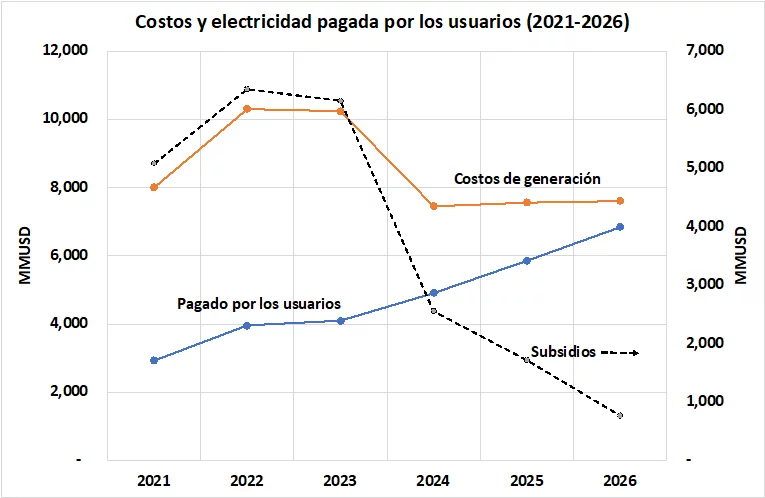

Teniendo en cuenta la evolución de la generación de electricidad por fuente (fig. 3) y la eliminación de la utilización de combustibles líquidos y del gas importado para generación (fig. 4), se estimaron los precios monómicos o costos totales de generación de la figura 7. Luego del pico cercano a 90 US$/MWh alcanzado en el año 2022 como consecuencia de la utilización de combustibles líquidos y de los elevados precios internacionales del GO, del GNL y del gas de Bolivia, la entrada en funcionamiento del GPNK permitiría bajar el costo de la energía a valores cercanos a los 60 US$/MWh a partir del año 2024. En el año 2022, los usuarios de las distribuidoras pagaron aproximadamente el 38 % del costo de la energía [2]. Considerando la disminución futura del costo de generación, se podría avanzar con una transición gradual hasta alcanzar el 90 % de cobertura en tres años (el 10 % remanente se destinaría a atender a la demanda con tarifa social). Esto significaría aumentos en el segmento de generación de la tarifa en moneda constante del 19 %, 16 % y 14 % en los años 2024, 2025 y 2026 respectivamente. Es importante tener en cuenta que los costos y tarifas son calculados aquí en dólares oficiales, lo cual posiblemente implique un fuerte aumento inicial en relación con el poder adquisitivo en caso de una devaluación importante a principios del año 2024. El crecimiento económico que cabe esperar luego del acomodamiento de las variables macroeconómicas permitiría, muy probablemente, que el establecimiento de un ajuste tarifario (adicional al aumento en moneda constante) sobre la base del promedio de aumento de los salarios resulte social, económica y políticamente el sistema más conveniente.

Los métodos de control del clima. Y un cuestionamiento de AgendAR

China lanzó un gigantesco operativo para que no lloviera en Pekín durante la ceremonia inaugural de los Juegos Olímpicos de 2008, y lo logró. Al año siguiente hubo otra campaña similar, también exitosa, para evitar lluvias durante los festejos del 60º aniversario del triunfo de la revolución comunista. Y el Servicio de Modificación del Estado del Tiempo de ese país se propuso para 2025 tener controladas las precipitaciones en el 60% de su inmenso territorio, o sea en una superficie igual al doble del tamaño de la Argentina.

Con 50.000 empleados en todo el país, China tiene hoy la mayor infraestructura mundial para el control de la lluvia. En este rubro, también han logrado avances significativos varios estados norteamericanos y Emiratos Árabes Unidos (EAU). Pero en este último caso, su Centro Nacional de Meteorología tiene objetivos diferentes. Con temperaturas que superan habitualmente los 45°C en EAU el bombardeo de nubes con cargas eléctricas busca provocar precipitaciones para adicionalmente refrescar el suelo en forma local.

“Recuerdo en 2015 cuando era Secretario General Adjunto de la ONU para el Cambio Climático, que estuvimos visitando China en ocasión del 70° aniversario del final de la Segunda Guerra, y pareció que organizaron todo para que el tiempo estuviera excelente mientras se realizaban los actos. Solo al día siguiente de la finalización de los eventos, cuando nos estábamos yendo, comenzó a llover”, comentó el científico húngaro-suizo Janos Pasztor, director ejecutivo del Carnegie Climate Governance Initiative (C2G), una organización con sede en Nueva York que, más allá de los proyectos referidos al estado del tiempo, busca catalizar la creación de una gobernanza efectiva para las tecnologías de modificación del clima.

La tecnología para controlar las lluvias tiene ya muchos años, pero no se trata de “crear” lluvia, sino de sembrar las nubes existentes con partículas de sal o yoduro de plata, a través de aviones, cohetes o dispositivos terrestres de difusión de humo, para que descarguen a tierra su humedad. Los científicos llevan más de un siglo estudiando estos dispositivos, pero China se está posicionando como líder mundial en esta práctica. “Lo que se logra es hacer que las nubes descarguen su humedad en determinado lugar y no en otro. De algún modo lo que se hace es ‘robar’ el agua que caería en otra ocasión u otro sitio. Por eso la polémica presentada por algunos países vecinos de China”, explicó Pasztor.

Mientras estos proyectos parecen haber sido exitosos en el manejo del estado del tiempo en el corto plazo, en todo el mundo hay estudios para trabajar sobre el clima y buscar la manera de modificar de forma más estable patrones como radiación solar y temperaturas en la tierra y en el agua.

Estas iniciativas son paralelas a los compromisos gubernamentales para combatir el cambio climático, que volverán a ser discutidos a fin de mes en la Cumbre del Clima 2023 de Dubái (entre el 30 de noviembre y el 12 de diciembre), y que apuntan básicamente a reducir las emisiones de carbono para limitar el aumento de la temperatura a 1,5 grados Celsius por encima de los niveles preindustriales, como se estableció en el Acuerdo de París de 2015.

Modificación del clima

Los expertos en modificación del clima no trabajan en cambios inmediatos sino en el largo plazo. Básicamente se dividen en iniciativas para la modificación de la radiación solar y para la remoción del dióxido de carbono existente en la atmósfera. De toda maneras, los estudios sobre la radiación solar se hallan aún en etapa teórica o experimental.

La mayoría de los planes para modificar la radiación apuntan a inyectar aerosoles en la estratósfera para que reflejen los rayos del sol hacia el espacio y no calienten tanto la Tierra.

“Una de las paradojas de la actualidad es que la Humanidad ya está inyectando aerosoles en la atmósfera con la utilización de combustibles fósiles. Y los científicos estiman que esos aerosoles reducen aproximadamente hasta un grado centígrado la temperatura del planeta. En otras palabras, si hoy se detuviera por completo la emisión de combustibles fósiles, la temperatura aumentaría hasta un grado”, explicó Pasztor.

El único proyecto que ya está en marcha para modificar la radiación solar es el de la empresa privada norteamericana Make Sunsets, que envió a la estratósfera un centenar de globos cargados con unos 10 gramos de dióxido de azufre cada balón. El supuesto objetivo de ese polvillo es reflejar los rayos del sol lejos hacia el espacio, enfriando la Tierra y mitigando temporalmente los efectos del cambio climático.

Básicamente, se imita el efecto de un volcán en erupción. Cuando en 1991 el Monte Pinatubo en Filipinas liberó unos 20 millones de toneladas de dióxido de azufre a la estratósfera, la temperatura global de la Tierra bajó en 0,4°C según el Servicio Geológico de Estados Unidos. El objetivo de Make Sunsets es por supuesto de una escala infinitamente menor.

Pero los expertos consideran que si unos cientos de aviones lograran desparramar regularmente aerosoles en la estratósfera alrededor del Ecuador, los vientos se encargarían luego de distribuirlos adecuadamente por todo el planeta y generar una especie de “efecto volcán”. El cielo seguramente se vería ligeramente más gris y se ignora qué efecto puede tener, por ejemplo, en la fotosíntesis o en la generación de energía solar.

“La situación de Make Sunsets y de otros emprendimientos en todo el mundo nos recuerdan la necesidad de contar con una autoridad planetaria que regule los proyectos de modificación del clima y que también la gente afectada pueda opinar. El impacto de actividades a gran escala para reducir la temperatura global, serán globales, sobre todos los ecosistemas y sobre todas las economías. Hasta ahora la iniciativa de Make Sunsets es de pocos cientos de miles de dólares y el impacto, si existe, es muy limitado. Pero qué pasaría si algún multimillonario decidiera lanzarse a un megaproyecto de varios billones de dólares. ¿Quién regularía su actividad?”, se preguntó Pasztor.

Por su parte la climatóloga argentina Inés Camilloni, del Programa de Investigación de Geoingeniería Solar de la Universidad de Harvard, explico una experiencia particular que se está realizando en Australia: el blanqueamiento de las nubes marinas. “El Marine Cloud Brightening (MCB) consiste en hacer que esas nubes sean más blancas bombardeándolas con sales marinas. Así tienen un mayor índice de reflexión de la luz hacia el espacio, y esto supuestamente permitiría, por ejemplo, proteger del calor la Gran Barrera de Coral”, explicó.

Además hay proyectos para modificar el impacto de la radiación solar en la superficie, por ejemplo, en Suiza y también en el Ártico. Algunos glaciares son cubiertos con láminas de plástico durante el verano para reflejar más luz solar y morigerar su derretimiento.

Remoción del dióxido de carbono

Unas iniciativas que están más directamente relacionadas con el objetivo de frenar el cambio climático y que ya se encuentran en una etapa más avanzada de concreción son las que apuntan a la remoción del dióxido de carbono existente en la atmósfera.

Por ejemplo, las empresas norteamericanas Noya o Verdox venden equipamiento para incorporar en los sistemas de aire acondicionado de los grandes rascacielos, que capturan el dióxido de carbono del ambiente.

También hay compañías que trabajan en la “mineralización del carbono” que se encuentra en el aire, convirtiéndolo en rocas o arena. Otras alternativas naturales son la plantación de árboles y algas que remueven el dióxido de carbono de la atmósfera.

Debate ético

Con tantos avances tecnológicos en la actualidad, la pregunta obvia es por qué la gran mayoría de los proyectos está solo en etapa teórica frente a la necesidad urgente de frenar el calentamiento global.

La respuesta no es económica porque, por ejemplo, tener algunos centenares de aviones esparciendo aerosoles en la estratósfera para disminuir la radiación solar, se estima que puede costar unos 10.000 o 20.000 millones de dólares, lo que es una cifra insignificante en el presupuesto global.

“Además de la falta de un sistema de gobernanza global que regule la implementación de los diferentes proyectos, aún hay mucha investigación por delante sobre los riesgos que implica intervenir en la modificación del clima”, consideró Camilloni. “Por ejemplo, la incorporación de aerosoles en la estratósfera podría llegar a ser beneficiosa en alguna región y desfavorable en otra. ¿Quién tomará la decisión de dónde se aplica un proyecto?”, advirtió.

Por su parte Pasztor coincidió con el análisis. “La verdad es que aún no sabemos qué impacto pueden tener en el largo plazo muchos de estos planes. Algunos cuestionan: ‘¿Somos dioses para intentar manipular algo tan inmenso como el clima?’ Y no se refieren necesariamente a ‘dioses’ en un sentido religioso sino en la cantidad de imponderables para los que, por nuestras limitaciones, aún no tenemos respuesta. Y creo que esos cuestionamientos deben ser atendidos”, concluyó el científico húngaro-suizo.

Comentario de AgendAR:

Estados Unidos propone a Brasil convertirse en el nuevo fabricante y exportador (cautivo) de chips

A finales de octubre aterrizó en Brasil una amplia e importante delegación encabezada por el Departamento de Estado y el EXIM Bank, el organismo oficial de crédito del gobierno de los EEUU, junto a gigantes tecnológicos como Google, Nvidia, Meta y Cloudfare. El encuentro tuvo lugar en la prestigiosa Universidad Estatal de San Pablo (USP).

La idea presentada es crear en Brasil un polo tecnológico para desarrollar y producir semiconductores, más conocidos como chips, con tecnología avanzada para abastecer no sólo el mercado interno, sino también el mundial, comenzando por Estados Unidos. Los semiconductores son pequeños procesadores que se utilizan en la tecnología de los teléfonos móviles, la informática avanzada, los drones y los equipos militares. Se han convertido en el corazón palpitante del mundo moderno.

Durante la reunión, la delegación estadounidense trató temas como la transferencia de tecnología y la financiación de la producción local. Precisamente durante la pandemia que paralizó la producción y las exportaciones, Brasil, como el resto del mundo, se enfrentó a una escasez de chips que obligó a la industria a ralentizar su producción.

En 2021, durante el gobierno de Bolsonaro, se liquidó la única fábrica de semiconductores de Brasil y del hemisferio sur, el Centro Nacional de Tecnología Electrónica Avanzada (CEITEC). La liquidación en el gobierno Lula fue posteriormente suspendida.

Creado en 2008 en Porto Alegre, sur de Brasil, el CEITEC cuenta con 180 empleados de alta tecnología que se vieron reducidos a producir únicamente chips para el rastreo de ganado y los peajes de las autopistas. El centro fue liquidado debido a su gestión financiera. A pesar de haber recibido cerca de 600 millones de reales entre 2010 y 2018, unos 122 millones de dólares, acumuló una pérdida de 160 millones de reales (33 millones de dólares) en el mismo período.

La propuesta que llega del exterior podría, por tanto, permitir a Brasil pasar página y mirar con más esperanza a un sector tan codiciado como el de los semiconductores a través de un proyecto internacional, liderado por los principales actores globales. Sólo el año pasado, el sector de los semiconductores movió 592.000 millones de dólares en todo el mundo.

El tema toca de cerca a Estados Unidos, que en su guerra, sobre todo comercial, con China busca nuevas alternativas, teniendo en cuenta también las amenazas geopolíticas recibidas de Pekín hacia su aliado Taiwán, baluarte mundial en este segmento específico de la producción.

Y que Washington está interesado lo demuestra el hecho de que durante la visita de Lula a Joe Biden en Estados Unidos, el pasado febrero, la secretaria de Comercio norteamericana, Gina Raimondo, abordó personalmente el asunto con el presidente brasileño. En agosto de 2022, la administración Biden aprobó la llamada Ley CHIPS y Ciencia, un paquete de medidas por valor de 52.700 millones de dólares para revitalizar la industria de los semiconductores.

Transcurrido un año, aún no se han entregado los fondos a los distintos gigantes del sector, que se han quejado por ello. “Empezaremos a dar fondos a finales de este año”, declaró Gina Raimondo en agosto, “estamos presionando a nuestro equipo para que vaya rápido, pero sobre todo para que haga las cosas bien”. El timing del viaje a Brasil hace presagiar, por tanto, que el paso de la teoría a la práctica será breve.

:quality(85)/cloudfront-us-east-1.images.arcpublishing.com/infobae/P76PK3OS5XBMQRAIEDVXYMQS4A.jpg 420w)

Y no es casualidad que la reunión se celebrara en la universidad pública más prestigiosa del país, la USP. El mundo de la investigación académica e industrial en Brasil es, de hecho, uno de los sectores más vibrantes para los chips en estos momentos.

El Centro de Investigación Avanzada Werner von Braun de Campinas, en el estado de San Pablo, por ejemplo, trabaja en el concepto de “fabless”, es decir, la producción de chips en espacios reducidos sin fábricas, en el sentido tradicional del término. Se trata de prototipos de minifábricas de chips en espacios de 40 m x 40 m que pueden producir semiconductores en cualquier lugar, ya sea en centros de investigación, parques tecnológicos o industrias.

La propuesta de EE.UU. para Brasil se integra en toda la región. La semana pasada, en la Cumbre de APEP, (The Americas Partnership for Economic Prosperity), un programa estadounidense de cooperación con las Américas, del que Brasil no forma parte, los países participantes debatieron sobre semiconductores y energías limpias, entre otros temas.

“Tenemos la intención de hacer de las Américas la sede de las cadenas de valor y suministro regionales más competitivas, inclusivas, sostenibles y resilientes del mundo”, afirmaron en una declaración conjunta. Por supuesto, Brasil tendrá que lidiar con la alta competitividad de México, que además de ser el octavo fabricante mundial de electrónica también produce chips (exportó 720 millones de dólares en semiconductores en 2021). Pero la demanda mundial es tan gigantesca que realmente hay lugar para todos.

El proyecto presentado en la USP es, por tanto, una excelente oportunidad para Brasil, por varias razones. En primer lugar, se crearán nuevos puestos de trabajo, pero sobre todo se profesionalizarán determinados sectores ocupacionales. El resultado podría ser un nuevo estímulo para el mundo laboral, que históricamente adolece de falta de especialización en Brasil.

Además, el alcance internacional del proyecto y la presencia de socios tecnológicos globales pueden evitar una mala gestión local. De hecho, según la prensa brasileña, el gobierno no ha tenido hasta ahora una estrategia clara en materia de semiconductores. Recientemente, la Secretaría de Desarrollo Tecnológico e Innovación consiguió obtener del Congreso la prórroga del Programa de Apoyo al Desarrollo Tecnológico de la Industria de Semiconductores (PADIS) hasta 2026.

Con este programa, el Planalto espera obtener hasta el equivalente de dos millones de dólares anuales en desgravaciones fiscales para el sector. El problema es que los paneles fotovoltaicos también se han incluido en el PADIS, perdiéndose así el objetivo principal del programa.

:quality(85)/cloudfront-us-east-1.images.arcpublishing.com/infobae/AONXJWLDAH56RLNYSD4QJHQ5CQ.jpg 420w)

Por lo tanto, la propuesta estadounidense también tiene el potencial de forzar al mundo de la política a un debate de mayor envergadura, el de un plan estructurado y a largo plazo para la industrialización del país.

Por último, Brasil podrá desafiar la hegemonía depredadora de China, que el viernes pasado inauguró en Cuba el Parque Industrial China-América Latina (CLIP), un polo de ciencia y tecnología en el que participan 53 empresas chinas, pero sobre cuyos objetivos no se han divulgado detalles.

Xi Jinping, durante la visita de Lula a Pekín el pasado abril, había propuesto acuerdos con Brasil en el sector de los semiconductores, pero si el gigante latinoamericano acepta la financiación estadounidense, según el Chips Act, no podrá hacer nada con China en el frente tecnológico durante 10 años.

“Los beneficiarios del Chips Act”, dijo Gina Raimondo en su presentación, “tendrán que firmar un acuerdo que limite su capacidad de ampliar la capacidad de fabricación de semiconductores en países extranjeros que consideremos sensibles durante un periodo de 10 años después de recibir el dinero”.

La Secretaria de Comercio estadounidense, aunque no nombró en ningún momento a China, añadió también que los beneficiarios “no podrán participar en actividades conjuntas de investigación o concesión de licencias tecnológicas con una entidad extranjera de un país sensible que impliquen tecnologías o productos sensibles”.

Cabe recordar que Brasil está experimentando una ola de innovación tecnológica en algunos sectores que promete dar importantes resultados. El pasado viernes, el presidente del Banco Central de Brasil, Roberto Campos Neto, afirmó que la autoridad monetaria introducirá la inteligencia artificial (IA) en el sistema financiero del país de aquí a 2025. “El objetivo”, dijo, “es utilizar la IA para que el proceso financiero sea mejor para las personas”.

Esta sería la etapa final de un proceso de innovación en el sistema financiero brasileño, que comenzó con el Pix, un sistema de transacciones instantáneas, y continuó con la banca abierta, es decir la integración de datos entre bancos, y la internacionalización de la moneda, a saber, nuevas regulaciones para facilitar las transacciones internacionales.

El Drex, es decir la creación de una moneda nacional, el real totalmente digital, es el último proyecto junto con la introducción de la inteligencia artificial en la que está trabajando el Banco Central. Y que el impulso tecnológico en Brasil sea favorable lo demuestra también la percepción de los ciudadanos de a pie.

Un reciente estudio de Getty Images, uno de los gigantes mundiales de la fotografía, realizado en 25 países y sobre una muestra de más de 7.000 encuestados revela que los brasileños son los más interesados en la Inteligencia Artificial. Cuatro de cada seis de ellos creen que la IA tendrá un impacto positivo en sus vidas.

Maria Zuppello

Comentario de AgendAR:

Las cláusulas restrictivas del Chips & Science Act como motor de inversiones del Eximbank son enormes, y además el objetivo principal. Por ahora, Washington parece estar ofreciéndole a la Universidad de San Pablo no un trampolín desde la informática académica a la industria. No, señor. Más bien, ofrece crédito para que Brasil compre plantas llave en mano con paquete tecnológico cerrado de Google, Nvidia, Meta y Cloudfare, onda «Me Tarzan, you Jane». El propósito parece múltiple, pero el fundamental parece evitar que los brasucas desarrollen sus propias unidades de diseño de chips para fabricación por terceros, o «fabless», es decir sin fábrica, o (peor aún) de que se asocien de ése u otros modos con China en el tema chips. Las capacidades de que Brasil se vuelva un país con oferta propia de alta tecnología siempre inquietaron a Washington. La única vez que en La Tierra de los Libres y Hogar de los Valientes se descuidaron, Embraer pasó ante sus narices de ser el diseñador de un pequeño biturbohélice de cabotaje, el Bandeirante, a lo que es hoy: el tercer fabricante mundial de jets de cabotaje de largo alcance con un solo pasillo. Para añadir vinagre a la herida, son muchas las rutas descentralizadas dentro de EEUU y Canadá en que se vuela con Embraer, y no para gran alegría de Boeing, Lockheed o Bombardier. Y es más: Embraer fabrica también en China y Europa. Las posibles alianzas tecnológicas con la Argentina tampoco son bien vistas por Washington. El plan conjunto de Embraer y la Fábrica Militar de Aviones FMA en Córdoba para construir un bimotor de cabotaje de alta velocidad propulsado a turbohélice, entre mediados de los ’80, llevó al CBA-123. Era una máquina de aspecto, configuración y aviónica avanzadísimas y distintivas, que en 1990 levantó interés y pedidos en las ferias aeronáuticas de París y Fairnborough. Pero no llegó a producirse en serie ni a venderse a aerolínea alguna, porque el plan fue abortado a pedido del State Department por dos magníficos vendepatrias recién devenidos presidentes: Carlos Menem aquí y Fernando Collor de Melo en Brasil. Perdimos un proyecto Mercosur en el que teníamos apostados U$ 300 millones, y los brasucas, el doble. Pero ellos conservaron Embraer, porque estaba bajo paraguas de la Fuerza Aérea Brasileña, que no había perdido ninguna guerra. En cambio Menem le cedió la FMA a Lockheed para que la empresa yanqui fingiera estar construyendo cazas de entrenamiento Pampa hasta 2011. Lentamente, eso sí, a algo más de media unidad por año, y a cambio de U$ 14 millones/año pagados por la Argentina. Más una indemnización de U$ 60 millones por haber dejado aquella enorme unidad industrial en estado de ruina cuando CFK les dijo (aeronáuticamente) que era hora de ahuecar el ala. En informática, los brasileños han sido una pesadilla pequeña pero recurrente de los EEUU. En 1990 Menem y Collor de Melo cerraron la ESLAI, (Escuela Latinoamericana de Informática) a pedido de Ronald Reagan y luego de George Bush. En la ESLAI, la Argentina ponía sus décadas de buena vinculación entre matemáticas y software, y Brasil añadía su capacidad de fabricación de hardware. Nuestros primos brasucas a fines de los ’80 eran el sexto mercado informático mundial, defendido por tasas aduaneras y abastecido de sorprendentes fierros propios. Uno los veía en todas las oficinas, aeropuertos y empresas, marcas que los argentinos ignorábamos que existieran. Nosotros también teníamos prontuario frondoso en Washington. Ya durante los ’70 las calculadoras de Fate-Cifra argentinas habían dominado el 30% del mercado sudamericano desde Tierra del Fuego hasta México, a excepción de Brasil, donde ya regían las leyes de protección de la electrónica local, que todavía no se llamaba informática. Las calculadoras tanto estudiantiles, contables o científicas Cifra se vendían hasta en Alemania, y -para inquietud de Texas Instruments- llegaban a la orilla sur del Río Grande. Cifra estaba a punto de presentar el modelo 1000, que habría sido la primera computadora de escritorio del mundo antes que la Apple 1 de Jobs y Wozniak. En esa estábamos los argentos cuando Cifra desapareció en meses, sepultada por importaciones libres japonesas y estadounidenses a precio de dumping. Explicación: un decreto del ministro de economía del Proceso, José Martínez de Hoz. Sumando recursos humanos nuestros en software y habilidades y capacidades industriales de ellos, entre 1986 y 1990, cuando se creó y existió la ESLAI, el Mercosur avanzó varios casilleros a tener la base de recursos humanos para intentar un par propio de Silicon Valleys, con sedes en la ciudad de Paraná, Brasil, y en el Parque Pereyra Iraola, La Plata. Eso estaba en marcha, y Menem y Collor nos barrieron las patas. Pero, para variar, nosotros volvimos a fojas cero y los brasileños no. Mantienen una industria propia, aunque menos deslumbrante que la que tuvieron en los ’80. En este caso me parece que a ojo de buen embajador no se han muerto lo suficiente, porque les están volviendo a barrer las patas, pero esta vez bajo disfraz de regalo. Un presente griego, cosa de que Brasil no reconstruya sus capacidades informáticas independientes. Increíblemente, las perdió no con Collor sino en el último año de la presidencia de José Sarney, fundador del Mercosur, a cambio de poder seguir exportando jugo de naranjas, cuero y zapatos a los EEUU. Las asociaciones empresariales de rubros más o menos primarios se aterraron de que EEUU les subiera los aranceles, y exigieron que su presidente obedeciera la orden de Ronald Reagan y liquidara la reserva de mercado informático de Brasil. Un buen ejemplo de cómo hay momentos de la historia en que las industrias más extractivas y primarias de un país periférico asesinan por la espalda a las más avanzadas de igual origen, a cambio de puerto libre en la metrópolis. Si tienen suficiente lobby, claro está, y no las protegen los milicos. Lo que le está ofreciendo Big Brother Biden a Brasil no son fábricas, son factorías cautivas por propiedad intelectual y por cláusulas restrictivas de venta, uso y asociación. Parece muy seguro de que le va a ir bien, pero el mundo se le ha vuelto demasiado multipolar y resbaloso al Joe. Espero que esta vuelta le salga muy mal. Los brasucas no resultaron socios fáciles. Pero son los que tenemos, y el Mercosur recién empieza.Daniel E. Arias